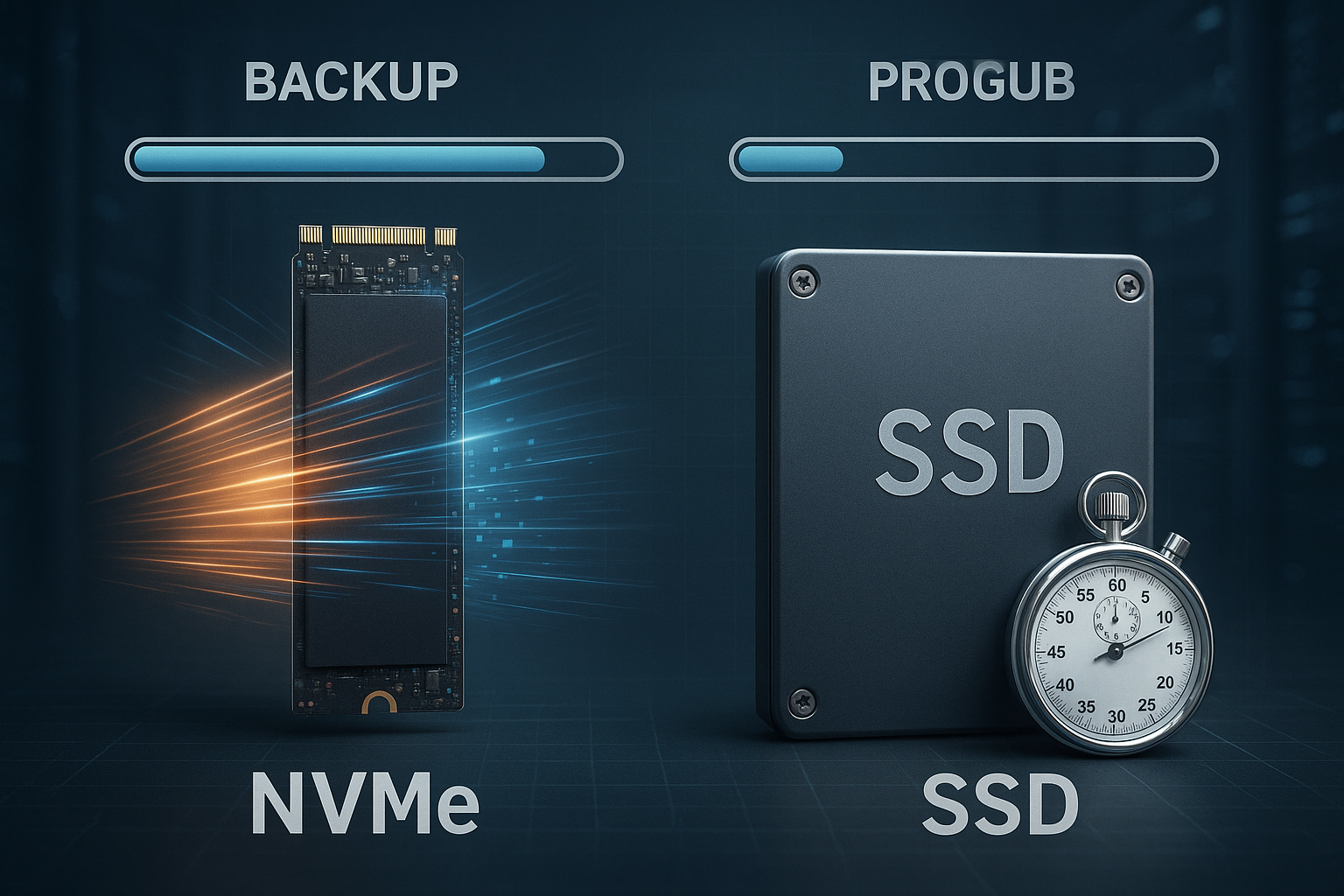

Storage-Klassen Backup entscheidet, wie schnell ich Daten sichere und wiederherstelle: NVMe reduziert die Sicherungsdauer gegenüber SATA-SSD je nach Durchsatz und Latenz oft um mehrere Minuten pro 100 GB. Dieser Beitrag zeigt, wie NVMe und SSD die Backup-Zeiten beeinflussen, welche Engpässe wirklich zählen und wie ich daraus eine belastbare Strategie für Hosting-Backups ableite.

Zentrale Punkte

- NVMe-Vorteil: Höherer Durchsatz, geringere Latenz, deutlich kürzere Backup- und Restore-Zeiten

- Backup-Typ: Voll, inkrementell, differenziell nutzen NVMe unterschiedlich stark

- Cloud-Klassen: S3-Standard für Tempo, IA/Archiv für Kostenkontrolle

- RAID/FS: Layout und Dateisystem beeinflussen reale Transferraten

- RTO/RPO: Tests und Monitoring sichern verlässliche Wiederanlaufzeiten

NVMe vs SATA-SSD: Warum Backups so stark profitieren

NVMe nutzt PCIe-Lanes und ein schlankes Protokoll, dadurch steigen Durchsatz und IOPS und die Latenz fällt deutlich gegenüber SATA-SSDs. SATA-SSDs liegen typischerweise bei 520–550 MB/s, während PCIe-4.0-NVMe bis zu 7.000 MB/s und PCIe-5.0-NVMe über 10.000 MB/s erreichen, was Voll-Backups stark beschleunigt. Für 100 GB bedeutet das vereinfacht: SATA-SSD benötigt etwa 3–5 Minuten, PCIe-4.0-NVMe 15–30 Sekunden, abhängig von Kompression, Verschlüsselung und Datei-Mix. Inkrementelle Jobs profitieren zusätzlich von der geringen Latenz, weil viele kleine Random-Reads/Writes schneller laufen. Wer tiefer vergleichen möchte, findet praxisnahe Unterschiede im NVMe/SSD/HDD Vergleich, der Performance und Kosten gegenüberstellt.

Backup-Typen und ihr Zusammenspiel mit der Storage-Klasse

Voll-Backups schreiben große Datenblöcke sequenziell, daher skaliert die backup speed nahezu linear mit dem Rohdurchsatz der Storage-Klasse. Inkrementelle Backups sichern Deltas seit dem letzten Lauf, hier zählt vor allem die niedrige NVMe-Latenz und hohe IOPS-Leistung bei vielen kleinen Dateien. Differenzielle Backups liegen dazwischen und profitieren in der Praxis von schnellen Reads beim Zusammenbau der Restore-Kette. Für Hosting-Backups minimiere ich so RTO und RPO: kleineres Delta, schnelle Medien, saubere Planungen. Ich kombiniere die Methoden und lasse Voll-Backups seltener laufen, während inkrementelle Jobs auf NVMe täglich oder öfter rotieren.

Durchsatz, IOPS und Latenz im Backup-Kontext

Für realistische Backup-Zeiten betrachte ich drei Kennzahlen: sequentiellen Durchsatz, zufällige IOPS und die Latenz pro Operation. Sequentieller Durchsatz bestimmt Voll-Backup-Dauer, IOPS und Latenz treiben inkrementelle Jobs, viele kleine Dateien und Metadaten. Kompression und Verschlüsselung können die Rohwerte begrenzen, wenn die CPU mit der Datenrate nicht Schritt hält. Ich messe darum beides: Storage-Performance und CPU-Auslastung während des Backups. Die folgende Tabelle zeigt typische Größenordnungen für 100-GB-Jobs in optimalen Bedingungen ohne Netzwerk-Engpass:

| Storage-Typ | Max. Lesen | Max. Schreiben | Übliche Backup-Zeit (100 GB) | Latenz |

|---|---|---|---|---|

| SATA SSD | 550 MB/s | 520 MB/s | 3–5 Minuten | 80–100 µs |

| PCIe 3.0 NVMe | 3.400 MB/s | 3.000 MB/s | 30–60 Sekunden | ~25 µs |

| PCIe 4.0 NVMe | 7.000 MB/s | 6.800 MB/s | 15–30 Sekunden | 10–15 µs |

| PCIe 5.0 NVMe | 12.000 MB/s | 11.000 MB/s | < 15 Sekunden | 5–10 µs |

In der Praxis liegen Werte oft darunter, weil Dateigrößen, Checksummen, Snapshots und CPU-Last bremsen, der Vorteil von NVMe bleibt aber klar sichtbar. Besonders bei parallelen Jobs gewinnt NVMe, da mehrere Queues pro Core abgearbeitet werden. Für viele kleine Dateien zählen IOPS und Latenz stärker als die reine MB/s-Angabe. Ich plane darum Puffer: 20–30% headroom auf der erwarteten Rate, damit Backups in Engpassphasen nicht aus dem Zeitfenster rutschen. Diese Reserve zahlt sich bei Nachtläufen und Engpässen im Netzwerk aus.

Cloud-Storage-Klassen im Backup-Mix

Für externe Kopien nutze ich S3-kompatible Klassen, wobei Standard die beste Wahl für schnelle Wiederherstellung ist. Infrequent-Access spart laufende Kosten, verlangt jedoch längere Abrufzeiten und gegebenenfalls Retrieval-Gebühren. Archivklassen eigenen sich für gesetzliche Aufbewahrung, nicht für zeitkritische Restores. Ich kombiniere lokale NVMe-Snapshots mit S3-Standard für frische Kopien und verschiebe ältere Stände in günstigere Klassen. Einen guten Einstieg in die Konzepte bietet Object-Storage im Hosting, der Vor- und Nachteile übersichtlich erläutert.

RAID und Dateisysteme: Tempo und Schutz

RAID-Layouts beeinflussen die effektive Backup-Rate erheblich, weil Stripe-Größe und Parallelität die Schreibmuster der Software treffen oder verfehlen. RAID 10 liefert hohe IOPS und solide Write-Performance, RAID 5/6 bietet mehr Kapazität, aber schwächere Random-Writes. Moderne Dateisysteme wie XFS oder ZFS verarbeiten parallele Streams effizient und erleichtern Snapshots, was die Backup-Fenster verkürzen kann. Für Linux-Hosts prüfe ich konkrete Workloads und wähle danach das Dateisystem. Eine knappe Entscheidungshilfe liefert ext4, XFS oder ZFS mit Performance-Hinweisen für gängige Szenarien.

Praxisbeispiel: 100 GB in Zahlen gerechnet

Angenommen, ich sichere 100 GB unkomprimiert mit einer Netto-Rate von 2.000 MB/s auf NVMe, dann liegt die Dauer bei rund 50 Sekunden. Auf einer SATA-SSD mit 500 MB/s brauche ich etwa 3,3 Minuten, plus Overhead für Checksummen und Metadaten. Nutze ich Kompression 2:1 und die CPU hält das Tempo, halbiert sich die benötigte Zeit oft. Eng wird es, wenn CPU oder Netzwerk nicht mithalten: Ein 10-GbE-Link limitiert bei 1.000–1.200 MB/s netto, egal wie schnell das Laufwerk ist. Daher teste ich Ende-zu-Ende und nicht isoliert, um die reale Backup-Zeit sicher zu planen.

Netzwerk und Software: Die oft übersehene Bremse

Backup-Software entscheidet, wie gut ich die Vorteile von NVMe überhaupt ausnutze. Single-Threaded-Pipelines sättigen schnelle Medien kaum, Multi-Stream und asynchrone I/O heben die Rate deutlich. Deduplication spart Übertragung und Speicher, kostet aber CPU und Random-IOPs, was günstige SSDs rasch auslastet. TLS-Verschlüsselung schützt die Daten, benötigt ebenfalls Rechenleistung; hier helfen AES-NI und Hardware-Offload. Ich prüfe deshalb parallel: Streams, Kompression, Dedup und Verschlüsselung – und passe die Pipeline an das Zielmedium an, statt blind Standardwerte zu übernehmen.

Kosten-Check: Euro pro gesparter Minute

Ich rechne gerne rückwärts: Spart NVMe gegenüber SATA-SSD bei 100 GB täglich im Mittel 2,5 Minuten, summiert sich das auf rund 75 Minuten pro Monat und 15,6 Stunden pro Jahr, pro Server. Bei einem Stundensatz von 50 € für Betriebszeit oder Opportunitätskosten ergibt das 780 € pro Jahr; in vielen Setups übersteigt der Nutzen den Mehrpreis einer NVMe-Lösung deutlich. Kritische Systeme mit kleinen Backup-Fenstern profitieren besonders, weil Verzug sofort in RTO-Risiken umschlägt. Wer Archivbestände lagert, kann kostengünstige Object-Storage-Klassen ergänzen und so Medienkosten senken. Diese Sicht hilft, Entscheidungen jenseits nackter MB/s-Zahlen betriebswirtschaftlich zu untermauern.

Sicherheitsfeatures ohne Tempoverlust nutzen

Unveränderliche Backups mit Object Lock schützen vor Manipulation, Ransomware und versehentlichen Löschungen. Auf NVMe-Quellen erstelle ich Snapshots, exportiere sie dediziert und übertrage sie mit Throttling, damit Produktions-IO nicht ausgebremst wird. Versionierung in S3 ermöglicht feine Wiederherstellungspunkte, die ich mit Lifecycle-Regeln altere. Verschlüsselung at-rest und in-transit bleibt Pflicht; ich messe aber die CPU-Kosten und wähle Parameter, die die Backup-Fenster einhalten. So bleibt Sicherheit keine Bremse, sondern Teil der planbaren Routine.

Migrationsstrategie ohne Downtime-Risiko

Beim Umstieg von SATA-SSD auf NVMe sichere ich zuerst den Status quo, erstelle Testläufe und messe die End-to-End-Zeiten. Danach migriere ich Workloads rollierend, beginnend mit den größten Backup-Fenstern, damit die Effekte sofort sichtbar werden. Snapshots und Replikation reduzieren Umschaltzeiten; ich plane Überlappung, bis neue Jobs stabil laufen. Backoff-Strategien verhindern, dass mehrere große Jobs zeitgleich Spitzen erzeugen. Dokumentation und ein kurzer Rollback-Pfad sichern den Betrieb, falls die ersten Nächte abweichen.

Konfiguration, die Tempo ermöglicht

Ich setze Queue-Depth und Parallelität so, dass die IO-Queues der NVMe-Laufwerke ausgelastet, aber nicht überfüllt sind. Größere Blockgrößen helfen bei Voll-Backups, kleine Blöcke und mehr Streams beschleunigen inkrementelle Läufe. Write-Through vs. Write-Back-Cache sowie Flush-Intervalle beeinflussen Latenz und Konsistenz; hier zählt der Einsatzzweck. Monitoring mit I/O-Wartezeiten, CPU-Steal und Netzwerk-Buffer zeigt Engpässe früh. Diese Signale nutze ich, um die Pipeline schrittweise zu schärfen, statt große Sprünge zu riskieren.

Applikationskonsistenz und Snapshots richtig umsetzen

Schnelle Medien helfen wenig, wenn die Daten inkonsistent sind. Ich erreiche applikationskonsistente Backups, indem ich vor dem Snapshot Datenbanken und Dienste gezielt beruhige: Pre-/Post-Hooks für freeze/thaw, kurze Flush-Intervalle und Journalschreibungen vermeiden Dirty Pages. Unter Linux nutze ich LVM- oder ZFS-Snapshots, bei XFS ggf. xfs_freeze, unter Windows VSS. Für Datenbanken gilt: Write-Ahead-Logs sichern und die Wiederherstellungskette dokumentieren. Virtuelle Maschinen bekommen quiesced Snapshots mit Gastagenten; so bleiben Filesystem- und App-Status stimmig. Die Folge: Weniger Restore-Überraschungen und verlässliche RPOs, ohne das Backup-Fenster unnötig zu verlängern.

Verifikation und Restore-Drills: Vertrauen entsteht im Rückweg

Ich prüfe systematisch, ob Backups lesbar und vollständig sind. Dazu gehören Ende-zu-Ende-Checksummen, Katalog-/Manifest-Prüfungen und stichprobenartige Restores auf eine isolierte Zielumgebung. Monatliche Restore-Drills für kritische Services messen echte RTOs und decken Schema- oder Berechtigungsfehler auf. Für deduplizierende Repositories sind regelmäßige Integrity-Scans Pflicht; Object-Storage profitiert von ETag-Vergleichen und periodischem Scrubbing. Ergebnisse landen in einem Runbook: Welche Schritte, welches Ziel, welche Dauer. So wird Wiederherstellung vom Ausnahmefall zur Routine – und Investitionen in NVMe zeigen ihren Nutzen im Moment der Wahrheit.

Hardware-Details: NAND-Typ, TBW, PLP und thermische Effekte

Nicht jede NVMe ist gleich: TLC-Modelle halten hohe Schreibraten länger als QLC, deren SLC-Cache unter Dauerlast schneller erschöpft. In Backups mit langen sequentiellen Writes kann das die Netto-Rate halbieren, sobald Thermal Throttling einsetzt. Ich achte auf ausreichende Kühlung, Heatsinks und Luftstrom, um Throttling zu vermeiden. Enterprise-Drives mit Power-Loss-Protection (PLP) sichern Daten bei Stromausfall und liefern konsistentere Latenzen. Die Kennzahl TBW (Total Bytes Written) setze ich in Relation zu meinem täglichen Backup-Volumen, um Abnutzung kalkulierbar zu halten. So bleibt die Pipeline stabil – nicht nur im Benchmark, sondern Nacht für Nacht.

Skalierung der Backup-Pipeline

Mit wachsender Hostzahl wird Orchestrierung entscheidend. Ich staffele Startzeiten, limitiere gleichzeitige Voll-Backups und reserviere Zeitfenster pro Mandant. Ein NVMe-gestützter Landing Zone-Cache auf dem Backup-Server puffert hohe Spitzen und tiered Daten asynchron in Object-Storage. Fair-Share-Algorithmen und IO-Rate-Limits verhindern, dass ein einziger Job alle Ressourcen beansprucht. Parallele Streams erhöhe ich nur so weit, wie Quelle, Ziel und Netzwerk mithalten; jenseits der Sättigung steigt Latenz, die Netto-Rate fällt. Ziel ist eine glatte Auslastungskurve statt nächtlicher Peaks – so halte ich SLAs auch dann, wenn unerwartet ein Restore dazwischenkommt.

Netzwerk- und OS-Tuning für hohe Raten

Für 10–25 GbE optimiere ich MTU (Jumbo Frames, wenn End-to-End möglich), TCP-Buffer, Receive-Side-Scaling und IRQ-Affinität. Moderne Stacks profitieren von io_uring bzw. asynchroner I/O; das senkt Syscall-Overhead und erhöht Parallelität. Ich wähle ein TCP-Staukontrollverfahren, das zu meiner Latenz passt, und nutze mehrere Streams, um High-BDP-Strecken auszulasten. Auf der CPU-Seite helfen AES-NI und eventuell Kompressions-Level, die zum Kerntakt passen (zstd: mittlere Stufen sind oft das beste Verhältnis aus Durchsatz und Ratio). Wichtig: Nicht an einem Ende optimieren und am anderen Engpässe erzeugen – Ende-zu-Ende messen bleibt Leitlinie.

Workload-spezifische Hinweise: Datenbanken, VMs und Container

Datenbanken sichere ich log-basiert und zeitpunktgenau: Base-Backup plus kontinuierliche Log-Erfassung reduziert RPO gegen null und beschleunigt Restores. Für VMs sind Change-Block-Tracking und agentenbasierte Quiesce-Methoden Gold wert, weil sie inkrementelle Volumenänderungen präzise erfassen. In Container-Umgebungen trenne ich Control-Plane-Daten (z. B. Cluster-Metadaten) von Persistent Volumes; Snapshots über CSI-Treiber auf NVMe-Backends verkürzen Backup-Fenster spürbar. Gemeinsamer Nenner: Applikationskonsistenz vor Roh-Performance. Erst wenn die Semantik stimmt, lohnt sich das Ausreizen von NVMe-Durchsatz und IOPS.

Regeln und Compliance: 3-2-1-1-0 in der Praxis

Ich etabliere die 3-2-1-1-0-Regel operativ: drei Kopien, zwei Medientypen, eine Offsite, eine unveränderliche, null ungeprüfte Fehler. Das bedeutet konkret: lokale NVMe-Snapshot-Kopie, sekundäre Kopie auf getrenntem Storage (anderes RAID/andere Verfügbarkeitszone) und Offsite in S3 mit Object Lock. Lifecycle-Policies bilden Aufbewahrungsfristen ab, Legal-Hold-Mandate bleiben von Löschläufen unberührt. Regelmäßige Prüfsummen und Test-Restores liefern das „0“. So werden technische Maßnahmen compliance-fähig und auditierbar – ohne die Backup-Fenster zu sprengen.

Benchmarking ohne Messfehler

Richtig messen heißt reproduzierbar messen. Ich wähle Blockgrößen und Queue-Depths passend zum Ziel (z. B. 1–4 MB für sequentielle Voll-Backups, 4–64 KB mit höherer Parallelität für Inkremente). Caches und Preconditioning berücksichtige ich, um SLC-Cache-Effekte sichtbar zu machen. Warmups, gleichmäßige Testdauer und Auswertung von P99-Latenzen zeigen, ob Spikes drohen. „dd“ mit OS-Cache liefert Scheinwerte; aussagekräftig sind asynchrone I/O-Pattern, die der Backup-Software ähneln. Parallel protokolliere ich CPU, IO-Wait und Netzwerk, damit die Ursache klar ist – nicht nur das Symptom.

Kapazitäts- und Kostenplanung über Zeit

Backups wachsen schleichend: neue Mandanten, größere Datenbanken, mehr Dateien. Ich plane Kapazität in drei Dimensionen: Durchsatz (MB/s pro Fenster), IOPS/Latenz (für Metadaten und kleine Dateien) und Speicherbedarf (primär, Offsite, unveränderlich). Auf NVMe dimensioniere ich 20–30% Reserve für Peaks, in S3 berücksichtige ich Abrufkosten und potenzielle Cross-Region-Replikation für Desasterfälle. Eine NVMe-gestützte Landing Zone erlaubt aggressives Dedupe/Kompression im Nachlauf und reduziert Object-Storage-Kosten. Wichtig: Trends monatlich überprüfen und Schwellwerte definieren, die rechtzeitig Hardware- oder Netzwerkupgrades auslösen.

Welche Plattform passt zu meinem Ziel?

Für produktive Hosting-Umgebungen prüfe ich, ob der Anbieter NVMe-RAID, Snapshots und S3-Anbindung performant umsetzt. Entscheidende Details sind PCIe-Generation, verfügbare Lanes, Netzwerk-Bandbreite und zuverlässige Offsite-Ziele. Ein Vergleich aktueller Angebote zeigt schnell, ob beworbene Raten realistisch erreichbar sind oder nur Peak-Werte darstellen. Wer sich orientieren will, kann die Eckdaten gegen Praxismessungen halten und Test-Backups auswerten. So vermeide ich Fehlinvestitionen und priorisiere die Bausteine, die die Backup-Zeit tatsächlich drücken.

Plan zum Mitnehmen

Zuerst messe ich die Ist-Zeit pro Job und erfasse RTO und RPO-Anforderungen pro Service. Anschließend identifiziere ich den Flaschenhals: Storage, CPU, Netzwerk oder Software-Pipeline. Danach upgrade ich gezielt: NVMe für primäre Daten und Backup-Cache, 10–25 GbE im Core, Multi-Stream und Kompression gemäß CPU. Es folgen Restore-Tests, die ich monatlich wiederhole, und ein Lifecycle-Plan für Offsite-Kopien. Für weitere Kontextinfos lohnt ein Blick auf den kompakten Überblick zu NVMe/SSD/HDD, der Performance, Kosten und Einsatzfelder knapp gegenüberstellt.

Kurz zusammengefasst

NVMe verkürzt Backup-Zeiten spürbar: mehr Durchsatz, viel mehr IOPS, deutlich weniger Latenz. Voll-Backups profitieren vom sequentiellen Tempo, inkrementelle Läufe vom schnellen Random-Access. Cloud-Klassen ergänzen lokale NVMe-Snapshots, wenn ich RTO und Kosten ausgewogen halten will. RAID-Layout, Dateisystem, Netzwerk und Software bestimmen, ob die Hardware ihr Potenzial zeigt. Wer systematisch misst, Engpässe beseitigt und die Pipeline anpasst, erreicht zuverlässige Storage-Klassen-Backups mit kalkulierbaren Zeitfenstern.