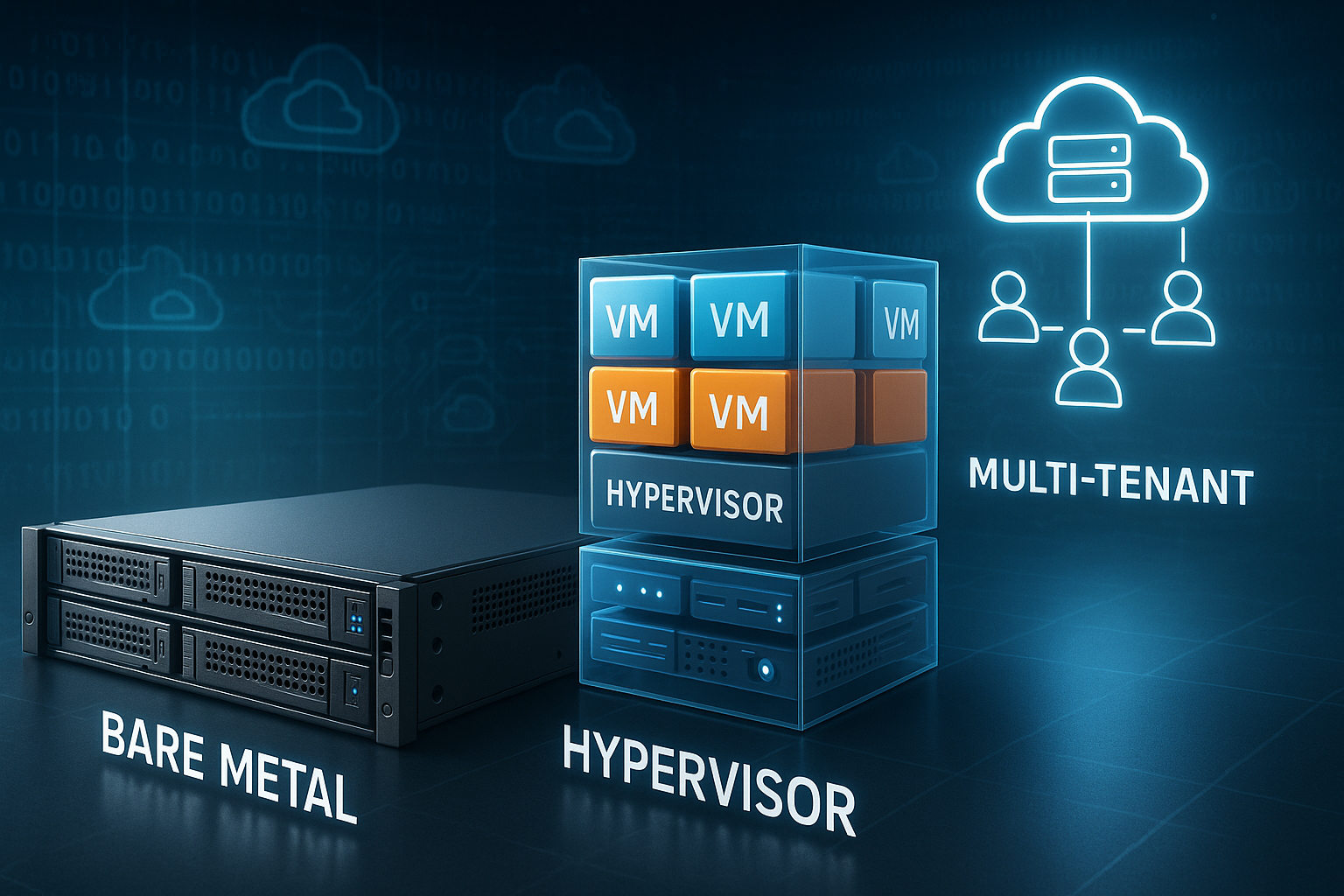

Ich erkläre den Webhosting-Jargon rund um Bare Metal, Hypervisor und Multi‑Tenant konkret und praxisnah. So verstehst du sofort, wie die Modelle funktionieren, worin sie sich unterscheiden und welche Wahl für deine Ziele passt – vom Einzelprojekt bis zur Plattform mit vielen Nutzern.

Zentrale Punkte

- Bare Metal: volle Hardwarekontrolle und höchste Performance.

- Hypervisor: Virtualisierung mit klarer Isolation und Flexibilität.

- Multi‑Tenant: effiziente Ressourcennutzung durch logische Trennung.

- Noisy Neighbor: Performance sauber managen und vorbeugen.

- Hybrid: sensible Lasten trennen, elastisch skalieren.

Bare Metal kurz erklärt

Bare Metal bedeutet: Ein physischer Server gehört exklusiv dir. Du teilst keine CPU, keinen RAM und keine SSD mit anderen. Ich bestimme das Betriebssystem, Storage-Setup und Sicherheitsfunktionen selbst. So kontrolliere ich jede Schicht vom BIOS bis zum Kernel. Für sensible Daten und Lastspitzen liefert Bare Metal die zuverlässigsten Reserven und die geringste Latenz.

Entscheidend ist die Abwesenheit von Nachbarn auf derselben Hardware. So vermeide ich den Noisy‑Neighbor-Effekt komplett. Ich plane Kapazität realistisch und halte Leistung konstant. Wer von Shared-Umgebungen kommt, spürt den Unterschied sofort. Ein schneller Einstieg gelingt mit einem Vergleich wie Shared-Hosting vs. Dedicated.

Hardware‑ und Netzwerkbasics für belastbare Plattformen

Die Basis entscheidet über Spielraum nach oben. Ich wähle moderne CPUs mit genügend Kernen und starker Single‑Thread‑Leistung, dazu ECC‑RAM für Integrität. Für Datenpfade setze ich auf NVMe‑SSDs mit hoher IOPS‑Dichte und plane dedizierte RAID‑Level oder ZFS‑Profile passend zum Workload. Netzwerkkarten mit SR‑IOV reduzieren Overhead und ermöglichen stabile Latenzen auch bei hohem Durchsatz. 25/40/100‑GbE sorgt für Reserven bei Replikation, Storage‑Traffic und Ost‑West‑Kommunikation.

Bei Bare Metal schöpfe ich Hardware‑Features direkt aus. In virtualisierten Stacks nutze ich Passthrough gezielt: NVMe direkt binden, SR‑IOV‑VFs an VMs durchreichen, CPUs mit CPU‑Pinning zuordnen. Im Multi‑Tenant‑Betrieb begrenze ich solche Privilegien bewusst, um Fairness und Isolation zu sichern. Ein durchdachtes Topologie‑Design (Leaf‑Spine, getrennte VLANs, eigene Management‑Netze) verhindert Engstellen und vereinfacht Fehlersuche.

Hypervisor: Typ 1 vs. Typ 2 in der Praxis

Ein Hypervisor ist die Virtualisierungsschicht zwischen Hardware und VMs. Typ 1 läuft direkt auf der Maschine und minimiert Overhead. Typ 2 sitzt auf einem vorhandenen Betriebssystem und eignet sich gut für Tests. Ich setze produktiv meist auf Typ 1, weil Isolierung und Effizienz zählen. Für Lab-Setups nutze ich Typ 2 wegen der einfachen Handhabung.

Wichtig sind CPU‑Pinning, NUMA‑Awareness und Storage‑Caching. Mit diesen Stellschrauben kontrolliere ich Latenz und Durchsatz. Snapshots, Live‑Migration und HA‑Funktionen verkürzen Ausfälle deutlich. Ich wähle Features nach Workload, nicht nach Marketing‑Begriffen. So bleibt die Virtualisierung berechenbar und leistungsfähig.

Storage‑Strategien und Datenlayout

Storage entscheidet über gefühlte Geschwindigkeit. Ich trenne Workloads nach Zugriffsprofil: transaktionale Datenbanken auf schnellen NVMe‑Pools mit geringer Latenz, analytische Jobs auf breitbandigem Storage mit hoher Sequenzleistung. Write‑Back‑Caching nutze ich nur mit Battery‑/Capacitor‑Backups, sonst drohen Datenverluste. TRIM und korrekte Queue‑Depths halten SSDs langfristig performant.

In virtualisierten Umgebungen wähle ich zwischen lokalem Storage (niedrige Latenz, aber kniffliges HA) und gemeinsamem Storage (einfachere Migration, aber Netzwerk‑Hop). Lösungen wie Replikation auf Block‑Ebene, Thin Provisioning mit striktem Monitoring und getrennte Storage‑Tiers (Hot/Warm/Cold) helfen, Kosten und Leistung zu balancieren. Für Backups setze ich immutable Repositories ein und teste regelmäßige Restores – nicht nur Prüf‑Checksummen, sondern echte Wiederanläufe von Systemen.

Multi‑Tenant verständlich gemacht

Multi‑Tenant heißt: Viele Mandanten teilen sich dieselbe Infrastruktur, bleiben aber logisch getrennt. Ich segmentiere Ressourcen sauber und definiere Quoten. Security‑Grenzen auf Netzwerk‑, Hypervisor‑ und Applikationsebene schützen Daten. Monitoring überwacht Last, I/O und ungewöhnliche Muster. So halte ich Kosten überschaubar und reagiere flexibel auf Peaks.

Die Stärke liegt in der Elastizität. Ich kann Kapazitäten zeitnah zuweisen oder freigeben. Pay‑as‑you‑Go‑Modelle reduzieren Fixkosten und fördern Experimente. Gleichzeitig setze ich harte Limits gegen Missbrauch. Mit klaren Policies skaliert Multi‑Tenant sicher und planbar.

Ressourcenplanung: Overcommit bewusst steuern

Overcommit ist kein Tabu, sondern ein Werkzeug. Ich definiere klare Obergrenzen: CPU‑Overcommit moderat (z. B. 1:2 bis 1:4, je nach Workload), RAM kaum bis gar nicht (Memory‑Ballooning nur bei kalkulierter Last), Storage‑Overcommit mit enger Telemetrie. Huge Pages stabilisieren speicherintensive Dienste, NUMA‑Binding verhindert Cross‑Socket‑Latenzen. Swap begreife ich als Airbag, nicht als Fahrmodus – zugewiesene RAM‑Budgets müssen reichen.

- CPU: Pin kritische Kerne, reserviere Host‑Cores für Hypervisor‑Aufgaben.

- RAM: Nutze Reservierungen und Limits, vermeide unkontrolliertes Ballooning.

- Storage: Plane IOPS‑Budgets pro Mandant und setze I/O‑Scheduler passend zum Profil.

- Netzwerk: QoS pro Queue, SR‑IOV für Latenz, dedizierte Pfade für Storage.

Noisy Neighbor, Isolation und spürbare Performance

Ich beuge Noisy‑Neighbor gezielt vor. CPU‑Limits, I/O‑Caps und Netzwerk‑QoS schützen Dienste vor Fremdlast. Dedizierte Storage‑Pools trennen latenzkritische Daten. Separate vSwitches und Firewalls schließen Querverkehr aus. Ich teste Szenarien mit Lastgeneratoren und messe Auswirkungen im Betrieb.

Transparenz schafft Vertrauen. Ich nutze Metriken wie P95‑ und P99‑Latenz statt Durchschnittswerten. Alerts reagieren auf Jitter, nicht nur auf Ausfälle. So erkenne ich Engpässe früh und greife ein. Mandanten bleiben isoliert, und die User‑Experience bleibt konstant.

Observability, Tests und belastbare SLOs

Ich messe systematisch: Metriken, Logs und Traces fließen zusammen. Für Services nutze ich die RED‑Methode (Rate, Errors, Duration), für Plattformen die USE‑Methode (Utilization, Saturation, Errors). SLOs definiere ich pro Dienst – etwa 99,9% mit P95‑Latenz unter 150 ms – und verknüpfe sie mit Alerts auf Error Budgets. So vermeide ich Alarm‑Fluten und fokussiere auf Nutzerwirkung.

Vor Changes fahre ich Lasttests: Baseline, Stress, Spike und Soak. Ich prüfe, wie sich Latenzen unter Stau verhalten und wo Backpressure greift. Chaos‑Experimente auf Ebene von Netzwerk, Storage und Prozessen verifizieren, ob Self‑Healing und Failover wirklich tragen. Synthetic‑Checks aus mehreren Regionen decken DNS‑, TLS‑ oder Routing‑Fehler auf, bevor Nutzer sie bemerken.

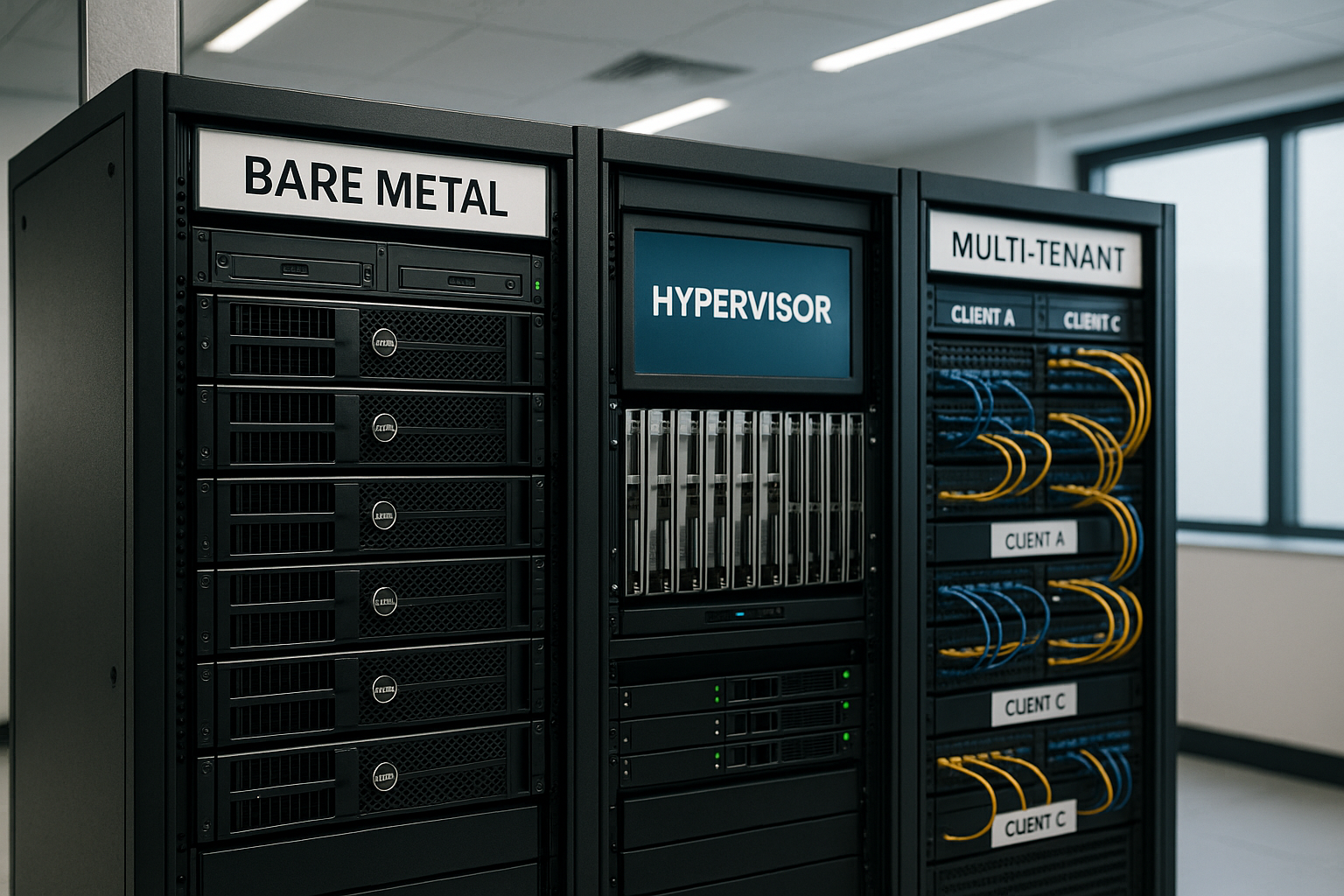

Vergleich: Bare Metal, Virtualisierung und Multi‑Tenant

Ich ordne Hosting‑Modelle anhand von Kontrolle, Leistung, Sicherheit, Skalierbarkeit und Preis. Wer maximale Kontrolle verlangt, greift zu Bare Metal. Wer flexibel bleiben will, wählt Virtualisierung auf Typ‑1‑Basis. Für dynamische Teams und variable Last lohnt Multi‑Tenant. Die folgende Tabelle zeigt die Unterschiede auf einen Blick.

| Kriterium | Bare Metal | Virtualisiert | Multi‑Tenant |

|---|---|---|---|

| Ressourcenkontrolle | Exklusiv, volle Hoheit | VM‑basiert, fein steuerbar | Softwareseitig zugeteilt |

| Performance | Sehr hoch, kaum Overhead | Hoch, geringer Overhead | Schwankt je nach Dichte |

| Sicherheit | Physisch getrennt | Isoliert per Hypervisor | Logische Trennung, Policies |

| Skalierung | Hardware‑gebunden | Schnell via VMs | Sehr flexibel und schnell |

| Preis | Höher, planbar | Mittel, nutzungsabhängig | Günstig bis moderat |

| Typische Einsätze | Compliance, Hochlast | Allround, Dev/Prod | SaaS, dynamische Projekte |

Ich treffe die Wahl nie isoliert. Ich berücksichtige Applikationsarchitektur, Team‑Know‑how und Budget. Backups, DR‑Pläne und Observability fließen ein. So bleibt die Plattform beherrschbar und skalierbar. Langfristige Betriebskosten zählen ebenso wie kurzfristige Miete.

Betriebsmodelle und Automatisierung

Ich automatisiere vom ersten Tag an. Infrastructure as Code definiert Netze, Hosts, Policies und Quoten. Golden Images und signierte Baselines reduzieren Drift. CI/CD‑Pipelines bauen Images reproduzierbar, rollieren Zertifikate und stoßen Canary‑Rollouts an. Für wiederkehrende Aufgaben plane ich Wartungsfenster, melde sie früh an und halte Rollback‑Pfade bereit.

Konfigurationsdrift kontrolliere ich mit periodischen Audits und gewünschtem Soll‑Zustand. Änderungen landen über Change‑Prozesse in die Plattform – klein, reversibel und beobachtbar. Secrets verwalte ich versioniert, mit Rotation und kurzlebigen Tokens. So bleibt der Betrieb schnell und gleichzeitig sicher.

Kosten, Skalierung und SLA alltagstauglich planen

Ich rechne nicht nur Hardware, sondern auch Betrieb, Lizenzen und Support ein. Für Bare Metal plane ich Puffer für Ersatzteile und Wartungsfenster. In Multi‑Tenant‑Umgebungen kalkuliere ich variable Last und mögliche Reserven. Ein klares SLA schützt Ziele für Verfügbarkeit und Reaktionszeiten. So bleiben Kosten und Service im Lot.

Skalierung beginne ich konservativ. Ich skaliere vertikal, solange es Sinn ergibt, und danach horizontal. Caching, CDNs und Datenbank‑Sharding stabilisieren Antwortzeiten. Ich messe Effekte vor Rollout in Staging. Dann setze ich die passenden Limits produktiv.

Migration sauber planen und Lock‑in minimieren

Ich beginne mit einem Inventar: Abhängigkeiten, Datenmengen, Latenzanforderungen. Danach entscheide ich zwischen Lift‑and‑Shift (schnell, wenig Umbau), Re‑Plattform (neue Basis, gleiche App) und Refactoring (mehr Aufwand, aber langfristig am effektivsten). Daten synchronisiere ich mit kontinuierlicher Replikation, finalem Cutover und klaren Rückfallebenen. Downtime plane ich, falls nötig, kurz und nachts – mit akribischem Runbook.

Gegen Vendor‑Lock‑in setze ich auf offene Formate, standardisierte Images und abstrahierte Netz‑ und Storage‑Schichten. Ich pflege Exit‑Pläne: Wie exportiere ich Daten? Wie repliziere ich Identitäten? Welche Schritte laufen in welcher Reihenfolge? So bleibt die Plattform beweglich – auch wenn die Umgebung wechselt.

Finanzsteuerung (FinOps) im Alltag

Kosten steuere ich aktiv. Ich setze Auslastungsziele pro Layer (z. B. 60–70% CPU, 50–60% RAM, 40–50% Storage‑IOPS), tagge Ressourcen sauber und schaffe Transparenz über Teams hinweg. Right‑Sizing entferne ich Leerlauf, Reservierungen nutze ich nur, wenn die Grundlast stabil ist. Bursts fange ich elastisch ab. Showback/Chargeback motiviert Teams, Budgets zu respektieren und Kapazität sinnvoll zu beantragen.

Virtualisierung oder Container?

Ich vergleiche virtuelle Maschinen mit Containern nach Dichte, Startzeit und Isolation. Container starten schneller und nutzen Ressourcen effizient. VMs liefern stärkere Trennung und flexible Gast‑Betriebssysteme. Mischformen sind üblich: Container auf VMs mit Typ‑1‑Hypervisor. Mehr dazu zeige ich in meinem Leitfaden Container oder VMs.

Wichtig ist das Ziel der Anwendung. Benötigt sie Kernel‑Funktionen, nutze ich VMs. Braucht sie viele kurzlebige Instanzen, setze ich Container ein. Ich sichere beide Welten mit Image‑Policies und Signaturen ab. Netzwerk‑Segmente trenne ich fein granular. So bleiben Deployments schnell und sauber.

Hybrid‑Modelle sinnvoll einsetzen

Ich trenne sensible Kerndaten auf Bare Metal und betreibe elastische Frontends virtualisiert oder im Multi‑Tenant‑Cluster. So kombiniere ich Sicherheit mit Agilität. Traffic‑Spitzen fange ich mit Auto‑Scaling und Caches ab. Datenflüsse sichere ich mit getrennten Subnetzen und verschlüsselten Links. Das senkt Risiko und hält Kosten kontrollierbar.

Ob der Mix passt, zeigt ein praxisnaher Vergleich wie Bare Metal vs. virtualisiert. Ich beginne mit klaren SLOs pro Service. Danach lege ich Kapazitäts‑Ziele und Eskalationspfade fest. Ich teste Failover realistisch und regelmäßig. So bleibt das Zusammenspiel verlässlich.

Sicherheit, Compliance und Monitoring auf Augenhöhe

Ich behandle Sicherheit nicht als Add‑on, sondern als festen Bestandteil des Betriebs. Härtung beginnt beim BIOS und endet beim Code. Secrets verwalte ich zentral und versioniert. Zero‑Trust‑Netzwerke, MFA und rollenbasierte Zugriffe sind Standard. Patching folgt festen Zyklen mit klaren Wartungsfenstern.

Compliance setze ich mit Logging, Tracing und Audit‑Trails um. Ich sammele Logs zentral und korreliere Ereignisse. Alarme priorisiere ich nach Risiko, nicht nach Menge. Übungs‑Drills halten das Team reaktionsfähig. So bleibt die Plattform prüfbar und transparent.

Datenresidenz, Löschkonzepte und Schlüsselverwaltung

Ich definiere klar, wo Daten liegen dürfen und welche Wege sie nehmen. Encryption‑at‑Rest und in‑Transit sind Standard, Schlüssel verwalte ich getrennt vom Speicherort. BYOK/HYOK‑Modelle nutze ich, wenn Trennung von Betreiber und Datenhalter gefragt ist. Für Löschungen gelten nachvollziehbare Prozesse: von logischem Delete über kryptografische Vernichtung bis zur physisch gesicherten Entsorgung von Datenträgern. So erfülle ich Anforderungen an Datenschutz und Nachweisbarkeit.

Energieeffizienz und Nachhaltigkeit

Ich plane mit Blick auf Effizienz. Moderne CPUs mit guten Performance‑pro‑Watt‑Werten, dichte NVMe‑Konfigurationen und effiziente Netzteile senken Verbrauch. Konsolidierung bringt mehr als Inseln: Lieber wenige gut ausgelastete Hosts als viele halb leere. Kühlung und Luftwege optimiere ich über Rack‑Anordnung und Temperaturzonen. Messung ist Pflicht: Power‑Metriken fließen in Kapazitäts‑ und Kostenmodelle. So spare ich Energie, ohne Leistung zu verschenken.

Zusammenfassung: Webhosting-Jargon souverän nutzen

Ich nutze Bare Metal, wenn volle Kontrolle, konstante Leistung und physische Trennung entscheidend sind. Für flexible Projekte setze ich auf Hypervisor‑basierte Virtualisierung und kombiniere sie bei Bedarf mit Containern. Multi‑Tenant wähle ich, wenn Elastizität und Kosteneffizienz Priorität haben und gute Isolation steht. Hybrid mischt die Stärken, trennt sensible Teile und skaliert dynamisch an der Kante. Mit klaren Messwerten, Automation und Disziplin bleibt der Webhosting‑Jargon keine Hürde, sondern ein Werkzeugkasten für stabile, schnelle Plattformen.