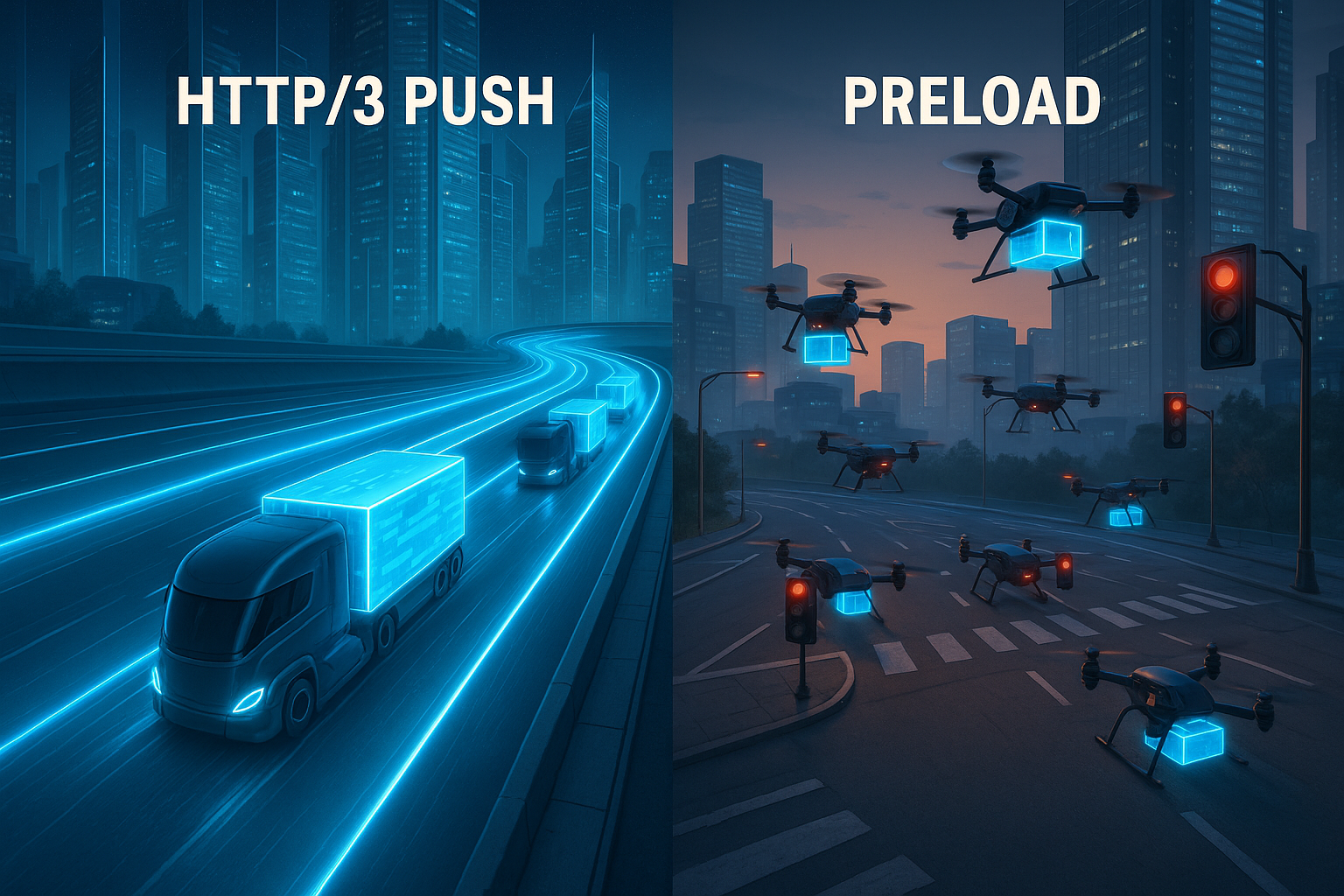

Ich vergleiche HTTP/3 Push und Preload anhand realer Messwerte und erkläre, wann welche Technik die http3 performance spürbar nach vorn bringt. Dafür analysiere ich QUIC‑Vorteile, Ladeprioritäten und typische Implementierungsfehler, die den First Paint und das Rendern bremsen.

Zentrale Punkte

Die folgenden Schwerpunkte fasse ich kompakt zusammen, damit du die Wahl zwischen Push und Preload schnell einordnen kannst.

- HTTP/3: QUIC eliminiert Head‑of‑Line‑Blocking und hält Streams bei Verlusten flott.

- Push: Proaktive Lieferung hilft bei sehr wahrscheinlichen Kern‑Assets, birgt aber Overhead.

- Preload: Deklarativ, kontrollierbar, risikoarm bei Priorisierung kritischer Ressourcen.

- Messwerte: Vorteile von HTTP/3 treten bei Paketverlust und vielen Assets deutlich hervor.

- Strategie: Kombination aus Preload und HTTP/3 erzielt in der Praxis häufig beste Ergebnisse.

HTTP/3 Push und Preload kurz erklärt

Ich setze Server Push ein, wenn der Server Dateien liefert, noch bevor der Browser sie anfordert, zum Beispiel CSS, JS oder Webfonts, die direkt fürs Rendering gebraucht werden. Diese Taktik legt Ressourcen früh in den Cache, spart Round‑Trips und kann den First Contentful Paint spürbar vorziehen. Preload steuere ich dagegen im Markup über link‑Tags, wodurch der Browser genau weiß, welche Datei er bevorzugt laden soll. Das schafft klare Prioritäten, reduziert Doppeltransfers und funktioniert mit HTTP/1.1, HTTP/2 und HTTP/3 gleichermaßen. Weil HTTP/3 auf QUIC basiert, lohnt sich ein Blick auf das QUIC‑Protokoll, das Streams getrennt behandelt und damit Staus auf Leitungsebene vermeidet.

Wie HTTP/3 die Ladezeit beeinflusst

Mit QUIC hebt HTTP/3 das Head‑of‑Line-Blocking auf, wodurch einzelne Paketverluste nicht mehr das Laden aller Dateien ausbremsen. Mehrere Streams laufen parallel, und Verluste betreffen nur den betroffenen Stream, was besonders bei vielen Assets hilft. 0‑RTT kann Verbindungen beschleunigen, wenn bereits eine Vorgeschichte besteht, wodurch frühe Anfragen schneller fließen. Auch die Steuerung der Sendeleistung und Fehlerkorrektur greift adaptiv, was unter Last den Takt hochhält. Wer direkte Gegenüberstellungen schätzt, findet im HTTP/3 vs. HTTP/2 Leistungsvergleich zusätzliche Perspektiven zu Latenz und Transferverhalten.

Push vs. Preload: Entscheidungslogik

Ich nutze Push, wenn ein Asset mit hoher Wahrscheinlichkeit sofort gebraucht wird, etwa das zentrale Stylesheet oder ein Above‑the‑Fold‑Script. In diesen Fällen kann die proaktive Lieferung eine sichtbare Zeitersparnis bringen, vor allem auf mobilen Netzen. Wird jedoch gepusht, obwohl der Client die Datei schon im Cache hat oder gar nicht benötigt, verschenkt das Bandbreite und verlängert Warteschlangen für wirklich wichtige Daten. Preload setze ich ein, wenn ich exakt steuern will, was priorisiert startet und wann der Parser die Anforderung sehen soll. Dadurch halte ich die Kontrolle in der Hand, vermeide doppelte Transfers und minimiere Fehlgriffe bei der Ressourcenwahl.

Leistungsvergleich in Zahlen

In Messumgebungen mit vielen gleichzeitigen Downloads bleibt HTTP/3 bei spürbaren Verlusten von über 8% deutlich reaktionsschnell, während HTTP/2 abfällt [4]. Bei 1‑MB‑Dateien und 2% Verlust zeigten Tests Ladezeiten von etwa 1,8 Sekunden mit HTTP/1 gegenüber 1,2 Sekunden mit HTTP/3 [5]. Diese Differenzen wirken sich direkt auf LCP, TTI und TBT aus, gerade wenn eine Seite viele separate Dateien initial anfordert. Für Single‑Page‑Apps und Medienseiten zahlt sich die Stream‑Trennung besonders aus, weil ein stockendes Asset die übrigen nicht mehr festhält. Ich bewerte die Zahlen immer im Kontext der Ressourcentypen, der Prioritäten und der Cache‑Treffer, denn hier liegen die größten Hebel für Tempo.

| Kriterium | HTTP/3 Push | Preload | Wirkung auf Metriken |

|---|---|---|---|

| Steuerung | Serverseitig, proaktiv | Clientseitig, deklarativ | Früher Start vs. klare Priorisierung |

| Risiko doppelter Transfers | Erhöht, wenn Cache bereits gefüllt | Niedrig, da exakt adressiert | Einfluss auf Bandbreite und TBT |

| Netzlast/Paketverlust | QUIC puffert Verluste pro Stream [4] | Profit durch HTTP/3‑Transportebene | Vorteile bei LCP/INP unter Last |

| Cache‑Trefferquote | Pushed Assets können verpuffen | Gezielte Nutzung vorhandener Caches | Geringere Wartezeiten bei Wiederkehrern |

| Implementierungsaufwand | Logik auf dem Server nötig | Markup‑Anpassungen im Head | Schneller Gewinn bei klaren Abhängigkeiten |

Browserstatus 2025: Push realistisch eingeordnet

Ich berücksichtige beim Planen, dass viele Browser Server Push in der Praxis stark einschränken oder ganz ignorieren. Das gilt besonders für Szenarien, in denen Doppeltransfers drohen oder Caches schon gefüllt sind. Dadurch bleibt Push eine Spezialwaffe für klar umrissene Fälle – etwa bei Erstbesuchen auf neuen Verbindungen – und kein Allheilmittel. In meinen Setups kalkuliere ich Push daher als optionalen Booster und stütze mich primär auf Preload und eine saubere Priorisierung auf Transportebene. Wo Clients Push nicht verwerten, falle ich automatisch auf Preload und frühe Hinweise zurück, ohne die Pipeline zu destabilisieren. Diese nüchterne Einordnung verhindert Enttäuschungen und hält die Roadmap realistisch.

Early Hints (103) und Preload im Team

Statt blind zu pushen, schicke ich bei passenden Setups Early Hints (103) mit Link: rel=preload vor dem eigentlichen HTML. So kann der Browser kritische Dateien starten, während der Server die Seite noch rendert. Das senkt die Zeit bis zum ersten Byte der Assets und erhält gleichzeitig die Kontrolle beim Client. In der Praxis funktioniert das zuverlässig mit HTTP/3 und bietet viele der Vorteile von Push – ohne die Risiken doppelter Transfers.

HTTP/1.1 103 Early Hints

Link: <https://cdn.example.com/app.css>; rel=preload; as=style; fetchpriority=high

Link: <https://cdn.example.com/app.js>; rel=modulepreload

HTTP/1.1 200 OK

...Ich nutze Early Hints vor allem für das Haupt‑CSS, kritische Webfonts und initiale Module. Wichtig: Die as-Typen müssen exakt passen, damit keine Zweitanforderungen ausgelöst werden. Außerdem achte ich darauf, dass CORS‑Vorgaben und Cache‑Header stimmig gesetzt sind. So kann ich die meisten Vorteile eines frühen Starts realisieren, ohne dass der Server zu viel rät.

Feinsteuerung der Prioritäten: Priority‑Header und fetchpriority

Neben Preload setze ich auf Priority‑Signale auf zwei Ebenen:

- Im HTML über

fetchpriority, z. B.fetchpriority="high"für kritische Styles oder Bilder im Viewport undfetchpriority="low"für Deko‑Assets. - Auf der Response über einen Prioritäts‑Header, der dem Transport eindeutige Hinweise gibt, welche Antworten bevorzugt fließen sollen. Das harmoniert mit HTTP/3 und entlastet die Leitung bei vielen parallelen Streams.

So arbeite ich client‑ und serverseitig zusammen: Der Browser trifft schnell die richtigen Entscheidungen, und der Server liefert sie mit passender Gewichtung aus. In Kombination mit QUIC reduziert das den Druck auf die Engpässe und verhindert, dass unbedeutende Dateien die kritische Bahn blockieren.

Preload präzise spezifizieren

Viele Probleme mit Preload entstehen durch kleine Inkonsistenzen. Ich vermeide sie mit sauberem, explizitem Markup:

<!-- Kritisches CSS -->

<link rel="preload" href="/css/app.css" as="style" fetchpriority="high">

<link rel="stylesheet" href="/css/app.css">

<!-- Kritische ES-Module -->

<link rel="modulepreload" href="/js/app.mjs">

<!-- Webfonts: CORS nicht vergessen -->

<link rel="preload" href="/fonts/Inter.woff2" as="font" type="font/woff2" crossorigin>

<!-- Hero-Bild im Above-the-Fold -->

<link rel="preload" as="image" href="/img/hero.webp"

imagesrcset="/img/hero_1x.webp 1x, /img/hero_2x.webp 2x"

imagesizes="(max-width: 800px) 100vw, 800px" fetchpriority="high">

<!-- Preconnect zu wichtigen Origins -->

<link rel="preconnect" href="https://cdn.example.com" crossorigin>Ich prüfe konsequent, dass die as-Werte den tatsächlichen Ressourcentypen entsprechen. Bei Fonts ist crossorigin Pflicht, sonst drohen doppelte Downloads. Für Skripte achte ich auf den Modus (type="module" vs. klassisch) und setze defer, damit der Parser nicht blockiert. Preload begreife ich als Ergänzung zum Render‑Pfad, nicht als Ersatz; die reguläre Einbindung bleibt erforderlich.

QUIC‑Details, die in der Praxis zählen

Ich plane HTTP/3 mit Blick auf Eigenschaften, die im Feld spürbar sind:

- Connection Migration: Wechselt ein Gerät von WLAN zu Mobilfunk, bleibt die QUIC‑Verbindung bestehen. Das vermeidet Neuhandshakes und schützt lange Transfers vor Abbrüchen.

- QPACK: Header‑Kompression ohne globales Head‑of‑Line‑Risiko. Das beschleunigt Seiten mit vielen kleinen Requests, insbesondere auf CDNs mit vielen wiederkehrenden Headern.

- 0‑RTT: Ich erlaube früh beschleunigte Anfragen nur für idempotente Ressourcen und evaluiere die Sicherheitssituation. Wo 0‑RTT greift, gewinne ich merklich Zeit beim Warmstart.

- Adaptives Congestion Control: In verlustbehafteten Netzen bleibt der Durchsatz stabiler. Zusammen mit Priorisierung ergibt das ein robustes Verhalten, wenn es darauf ankommt.

Diese Features entfalten ihre Wirkung erst mit sauberer Server‑ und CDN‑Konfiguration. Ich sorge für TLS 1.3, kurze Zertifikatsketten, stapelnde Status‑Infos und stimmige Fallbacks, damit auch ältere Clients performant bedient werden.

Ressourcenpriorisierung richtig einsetzen

Ich definiere Kern‑Assets eindeutig: das kritische CSS, Fonts für sichtbaren Text, und Skripte, die den Above‑the‑Fold‑Bereich betreffen. Diese Dateien erhalten die höchste Priorität via Preload oder werden in besonderen Fällen gepusht. Bilddateien für später sichtbare Inhalte lasse ich nachrangig oder via lazy loading nachrücken, damit Render‑Pfad und Interaktion früh bereitstehen. Für Drittanbieter‑Ressourcen wäge ich den Nutzen genau ab und setze bei Bedarf preconnect, damit die Handshakes rechtzeitig starten. So bleibt die Leitung für wirklich wichtige Daten frei, und ich verhindere, dass Deko‑Assets den Start blockieren.

Für die Praxis halte ich mich an eine kurze Entscheidungsroutine:

- Ist das Asset für FCP/LCP kritisch und fast immer nötig? → Preload, optional Early Hints; selektiver Push nur, wenn messbar überlegen.

- Ist die Nutzung variabel oder nutzerabhängig? → Kein Push; allenfalls Preload nach geprüften Heuristiken oder nachgelagert laden.

- Ist das Asset groß? → Preload bevorzugen; Push nur, wenn Bandbreite gesichert und Cache‑Treffer unwahrscheinlich sind.

- Gibt es Alternativen wie Inline‑Critical‑CSS oder Code‑Splitting? → Vorziehen; sie verkürzen Pfade und senken Gesamtrisiko.

Umsetzung: Checkliste aus der Praxis

Ich starte mit einem Audit der Startseite und der wichtigsten Templates und markiere alle Dateien, die für den ersten sichtbaren Bereich nötig sind. Danach lege ich Preload‑Einträge im Head an, teste Prioritäten und prüfe, ob doppelte Anfragen auftreten. Wo sich ein früher Transfer stark lohnt, erwäge ich selektiven Push und messe die Wirkung auf LCP und TTI. Für QUIC/HTTP‑3 aktiviere ich Unterstützung auf CDN oder Server und gleiche die Priorisierungsregeln mit den kritischen Pfaden ab. Für Schritt‑für‑Schritt‑Hilfen hilft mir eine praxisnahe HTTP/3 Implementierung, damit Konfiguration, Tests und Rollout strukturiert ablaufen.

Ergänzend etabliere ich folgende Routinen:

- Early Hints einschalten und mit den gleichen Link‑Einträgen speisen wie den finalen HTML‑Head.

- Cache‑Strategie mit Versionierung:

app.abcdef.css, langemax-age,immutable, damit Wiederkehrer profitieren. - Service Worker auf Preload‑Flows abstimmen, damit keine Doppelarbeit im Netz und im SW‑Cache entsteht.

- Prioritäts‑Header auf dem Origin/CDN setzen, damit HTTP/3 die wirklich wichtigen Antworten bevorzugt.

- Feature‑Flags für Push/Preload, um A/B‑Tests schnell und risikolos zu fahren.

Typische Fehler und wie ich sie vermeide

Ich pushe keine Assets, die der Browser vielleicht schon im Cache hält, denn das verschwendet Bandbreite. Stattdessen prüfe ich Cache‑Header, Versionierung und Gültigkeit, damit Wiederkehrer von frischen Treffern profitieren. Ich überlade Preload nicht, denn ein Dutzend kritischer Einträge kann die Leitung verstopfen und Prioritäten verwässern. Bei Fonts achte ich auf passende Formate und unicode‑ranges, damit der Transfer schlank bleibt und sichtbarer Text zügig erscheint. Zudem teste ich auf unterschiedlichen Geräten und Funknetzen, weil die wahre Wirkung erst unter realen Bedingungen sichtbar wird.

Diese Fallen habe ich besonders im Blick:

- Mismatch zwischen

asund Ressourcentyp (z. B.as="script"für Module) → führt zu unnötigen Zweitanforderungen. - Fehlendes crossorigin bei Fonts → doppelte Downloads oder blockierende Fehler.

- Zu breite Preload‑Listen → unterminieren Prioritäten; ich limitiere auf Kern‑Assets.

- Unklare Rollen von Inline‑Critical‑CSS vs. Preload → ich entscheide pro Seite und vermeide Mischformen, die beide Wege belasten.

- Blindes Pushen ohne Cache‑Wissen → Push bleibt eine Wette; ich messe und sichere mit Early Hints ab.

Monitoring und Messmethoden

Ich messe LCP, TTI, TBT und INP mit Lighthouse, ergänze Laufzeitdaten via RUM und vergleiche Varianten per A/B‑Tests. WebPageTest oder ähnliche Tools helfen mir, Wasserfalldiagramme auszuwerten und zu erkennen, ob Preload und Push wie geplant greifen. Die Kombination aus Labor‑ und Felddaten zeigt, ob Optimierungen tragfähig sind oder Nebeneffekte erzeugen. Ich prüfe regelmäßig, wie Browser mit Server Push umgehen, da manche User Agents Pushed Assets einschränken oder ignorieren [8]. Auf Basis dieser Daten entscheide ich, welche Technik ich weiter ausrolle und welche ich zurücknehme.

Für belastbare Aussagen differenziere ich:

- Kalt vs. warm: Erstbesuch ohne Cache getrennt von Wiederkehrern auswerten.

- Netzprofile: 4G/5G mit realistischen Verlusten, High‑RTT‑Szenarien und stark ausgelastete Zellen simulieren.

- Request‑Anzahl: Seiten mit wenigen großen vs. vielen kleinen Dateien getrennt betrachten.

- Gerätemix: Mittelklasse‑Mobilgeräte mit schwächerer CPU, weil Parser‑ und Dekompressionskosten dort stärker wiegen.

Ich dokumentiere pro Experiment exakt: Build‑Versionen, Preload‑Einträge, Prioritäts‑Header, Push‑Regeln, Early‑Hints‑Status. So kann ich Effekte reproduzieren und bei Bedarf rasch zurückdrehen.

Hosting und Infrastruktur als Hebel

Ich achte auf Server mit zeitgemäßer HTTP/3‑Unterstützung, solider TLS‑Konfiguration und sauberer Priorisierung. Ein performantes CDN mit guter PoP‑Abdeckung senkt Latenzen zu mobilen Nutzern und macht die Vorteile von QUIC leichter greifbar. Auch saubere Konfiguration der TCP‑Fallbacks für ältere Clients spielt eine Rolle, damit niemand benachteiligt wird. Für Budgets kalkuliere ich den Effekt zuerst, denn oft reichen kleinste CDN‑Anpassungen oder HTTP/3‑Aktivierungen ohne hohe Zusatzkosten im niedrigen zweistelligen Euro‑Bereich pro Monat. Je stärker die Basis, desto klarer treten die Effekte von Push und Preload im Alltag hervor.

Außerdem prüfe ich, ob die Infrastruktur folgende Punkte unterstützt:

- Early Hints vom Edge, damit Preloads noch vor dem HTML starten.

- Extensible Prioritization bzw. Prioritäts‑Header, die vom Proxy respektiert werden.

- Feinkörnige Regeln pro Pfad/Dateityp, um nur ausgewählte Assets zu pushen oder per Preload hervorzuheben.

- Transparente Metriken auf Edge‑Ebene (Hitrate, RTT, Verlust, Repriorisierungen), um Ursachen von Abweichungen sichtbar zu machen.

Abschließende Einordnung

Ich sehe HTTP/3 mit QUIC im Vorteil, sobald Funknetze, viele parallele Streams oder Verlustsituationen ins Spiel kommen [4][5]. In kontrollierten Setups liefert Preload eine sichere Priorisierung, weil ich exakt festlege, was wirklich zuerst laufen soll. Push nutze ich gezielt für unverzichtbare Ressourcen, deren Nutzen sich konsistent zeigt und deren Größe im Rahmen bleibt. Die beste Wirkung erreiche ich, wenn ich Preload für Prioritäten, HTTP/3 für den Transport und sorgfältig dosierten Push kombiniere. Wer so vorgeht, senkt Ladezeiten spürbar, schützt die Bandbreite der Nutzer und hebt die wahrgenommene Qualität der Seite deutlich an.