Viele Websites scheitern am PHP Memory Limit, obwohl kein Fehler erscheint. Ich zeige, wie diese unsichtbaren Abstürze entstehen, was sie triggert und wie ich mit gezieltem Tuning Speicherfehler zuverlässig stoppe.

Zentrale Punkte

- Silent Errors blockieren Seiten, ohne sichtbare Meldung.

- Limits von 64–128M reichen oft nicht mehr.

- Plugins und große Datenbanken treiben RAM hoch.

- Hosting-Tuning mit FPM und OPcache senkt Risiko.

- Monitoring deckt Engpässe früh auf.

Was passiert bei Memory Exhaustion?

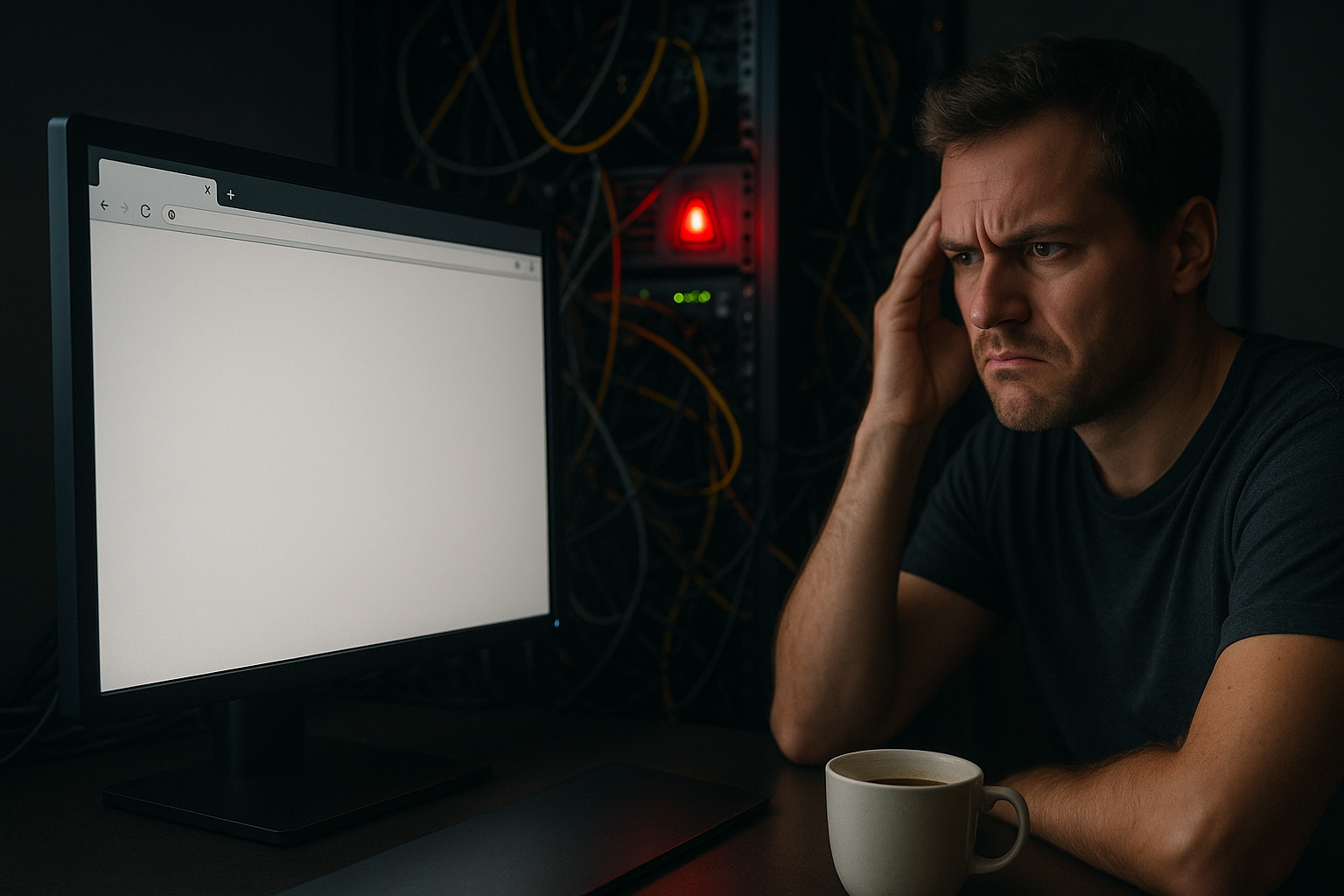

Wenn ein Skript seinen zugewiesenen Speicher überschreitet, erzeugt es oft keinen sichtbaren Fehler. Stattdessen beendet der Prozess abrupt seine Arbeit und hinterlässt einen weißen Bildschirm oder eine blockierte Anfrage, die wie ein Timeout wirkt. Auf Shared-Servern greifen zusätzliche Schutzmechanismen, die Prozesse vorzeitig beenden. So verhindert die Plattform die Überlastung, doch für dich wirkt es wie ein mysteriöser Hänger. Ich sehe in Logs dann Lücken, abgebrochene Requests oder FPM-Neustarts, während die eigentliche Ursache im RAM-Limit liegt.

Wichtig ist die Abgrenzung: 504- oder 502-Fehler wirken wie klassische Timeouts, sind aber oft Folge eines vorzeitigen Prozessabbruchs. Das memory_limit greift pro Request; es reserviert keinen RAM im Voraus, sondern beendet beim Überschreiten hart. Gelangt der Server selbst in den Swap, verlängern sich Antwortzeiten deutlich, obwohl das Limit formal nicht erreicht scheint – praktisch ist der Effekt derselbe: Nutzer sehen Hänger oder leere Seiten.

Silent Errors ohne Meldung erkennen

Silent Errors entstehen oft, weil Produktionssysteme Fehlermeldungen unterdrücken und PHP-FPM bei Engpässen Worker neu startet. Nah am Limit springt die Garbage Collection häufiger an und erhöht die Latenz, ohne eine klare Meldung auszugeben. Unter Druck beendet der OOM-Killer Prozesse, bevor PHP eine Ausgabe schreiben kann. In der Praxis sehe ich 502/503-Gateway-Fehler, sporadische Whitescreens und sporadisch leere Logs. Wer verstehen will, wie Limits Response-Zeiten treiben, liest die kompakten Performance-Effekte des PHP Memory Limit; so ordne ich Symptome besser ein.

Ich prüfe ergänzend die FPM-Slowlogs und den FPM-Status. Der Status zeigt laufende/idle Worker, durchschnittliche Laufzeiten und aktuelle Queue-Längen. Häufen sich „terminated“ oder „out of memory“ in Error-Logs, oder steigen die Slowlog-Einträge parallel zu Peaks, ist das ein verlässlicher Indikator. In Nginx- oder Apache-Error-Logs erkenne ich zudem Muster in 502/504-Fehlern, die mit FPM-Restarts oder Pool-Überläufen zusammenfallen.

Typische Ursachen im Alltag

Ressourcenhungrige Plugins laden große Arrays und Objekte in den Speicher; laufen mehrere davon parallel, steigt der Verbrauch sprunghaft. Bildoptimierer, Crawler, SEO-Scanner oder Pagebuilder greifen massiv zu und halten Daten länger im RAM als nötig. Eine über die Jahre angewachsene Datenbank mit Revisions, Transients und Spam-Kommentaren verstärkt das Problem, weil Abfragen mehr Ergebnisse in den Prozess ziehen. Bei Hochlast, etwa in Shops mit Filtersuchen, kämpfen mehrere PHP-Worker um begrenzten Speicher. Zusätzlich erhöhen viele aktivierte Erweiterungen den Grundverbrauch, sodass wenig Headroom für echte Anfragen bleibt.

Besonders kritisch sind Bild- und PDF-Verarbeitung (Imagick/GD), Importer, Backup-Plugins, Volltext-Suchen und REST-Endpunkte, die große JSON-Payloads verarbeiten. Cron-Jobs (z. B. Index-Rebuilds, Feeds, Syncs) laufen gerne parallel zu Besuchern und verursachen so unerwartete Peaks. In Admin-Bereichen addieren sich Editor-Previews, Metaboxen und Live-Validierungen – das erklärt, warum Backends häufiger an WP_MAX_MEMORY_LIMIT stoßen als Frontends.

So prüfe ich Limit und tatsächlichen Verbrauch

Ich starte mit einer kurzen PHP-Info oder einem CLI-Check, um das effektive memory_limit und aktive Module zu sehen. In WordPress logge ich via Debug-Modus den Peak-Speicher pro Request und erkenne, welche Aufrufe besonders viel verschlingen. Für einen schnellen Test setze ich eine Testseite auf, deaktiviere Plugins in Blöcken und beobachte den Peak bei identischem Seitenaufruf. In Hosting-Panels oder via ps/top/wpm ihnterfrage ich, wie viel jeder FPM-Worker im Schnitt braucht. So belege ich Engpässe messbar und entscheide fundiert über das nächste Limit.

// Kurztest in WordPress (wp-config.php)

define('WP_DEBUG', true);

define('SCRIPT_DEBUG', true);

// Peak-Speicher z.B. via Query Monitor oder Log-Ausgaben prüfen

Für reproduzierbare Messungen logge ich die Spitzen direkt aus PHP heraus. So sehe ich auch in produktionsnahen Tests, wie viel einzelne Controller, Hooks oder Shortcodes verbrauchen:

// In einer MU-Plugin-Datei oder functions.php:

add_action('shutdown', function () {

if (function_exists('memory_get_peak_usage')) {

error_log('Peak memory: ' . round(memory_get_peak_usage(true) / 1024 / 1024, 1) . ' MB | URI: ' . ($_SERVER['REQUEST_URI'] ?? 'CLI'));

}

});

Wichtig: CLI und FPM nutzen oft unterschiedliche php.ini-Dateien. Ein Skript, das via WP-CLI problemlos läuft, kann im Webkontext scheitern. Ich prüfe daher beide Kontexte explizit (php -i vs. php-fpm) und teste ggf. mit php -d memory_limit=512M script.php die Grenzen eines Jobs.

PHP Memory Limit richtig erhöhen

Ich erhöhe das Limit schrittweise und teste nach jedem Schritt die Stabilität. Zuerst reicht oft eine Anhebung auf 256M, für datenintensive Workloads gehe ich auf 512M und beobachte die Peaks. Wichtig: Ein überzogenes Limit löst das Grundproblem nicht, weil ineffiziente Abfragen weiter Arbeit erzeugen. Beachte außerdem, dass FPM-Worker multipliziert mit Limit und Prozessanzahl schnell Gesamtram sprengen. Deshalb kombiniere ich die Erhöhung mit Optimierungen an Plugins, Datenbank und FPM-Parametern.

// 1) wp-config.php (vor "Das war’s, hören Sie auf zu editieren!")

define('WP_MEMORY_LIMIT', '256M');

# 2) .htaccess (vor "# END WordPress")

php_value memory_limit 256M

; 3) php.ini

memory_limit = 256M

; ggf. 512M testen

// 4) functions.php (Fallback, falls nötig)

ini_set('memory_limit', '256M');

Für Admin-Tasks setze ich ergänzend ein höheres Limit, ohne das Frontend unnötig aufzublähen:

// wp-config.php

define('WP_MAX_MEMORY_LIMIT', '512M'); // nur für /wp-admin und bestimmte Tasks

Typische Fallstricke: Bei PHP-FPM greifen php_value-Direktiven in .htaccess nicht – hier nutze ich .user.ini oder die FPM-Pool-Konfiguration. Außerdem überschreiben manche Hoster kundenseitige Einstellungen wieder; ich validiere stets das effektive Limit zur Laufzeit (ini_get('memory_limit')). memory_limit = -1 ist in der Produktion tabu, weil es Lecks oder Spikes nicht mehr begrenzt und den Server in die Knie zwingt.

Hosting-Tuning: OPcache, FPM und Erweiterungen

Ein tragfähiger Fix kombiniert Limit-Anhebung mit gezieltem Tuning. Ich dimensioniere OPcache großzügig genug, damit häufige Skripte im Cache bleiben und weniger Re-Compilation anfallen. Bei PHP-FPM stelle ich pm.max_children, pm.max_requests und pm.memory_limit stimmig ein, sodass Anfragen nicht hungern, aber der Server Luft behält. Unnötige PHP-Extensions entferne ich, weil sie den Basisspeicher jedes Workers aufblähen. So gewinne ich Headroom, senke Latenz und reduziere die Gefahr stiller Abbrüche deutlich.

Für OPcache haben sich solide Defaults bewährt, die ich je nach Codebasis anpasse:

; opcache-Empfehlungen

opcache.enable=1

opcache.memory_consumption=256

opcache.interned_strings_buffer=16

opcache.max_accelerated_files=20000

opcache.validate_timestamps=1

opcache.revalidate_freq=2

FPM dimensioniere ich anhand realer Messwerte. Als Faustregel: (Gesamt-RAM − OS/Services − DB − OPcache) / durchschnittlicher Worker-Verbrauch = pm.max_children. Beispiel: 8 GB RAM, 1,5 GB OS/Daemonen, 2 GB DB, 256 MB OPcache, 180 MB/Worker → (8192−1536−2048−256)/180 ≈ 24, also starte ich mit 20–22 und beobachte Queue und Swap. pm.max_requests setze ich moderat (z. B. 500–1000), um Leaks zu kappen, ohne zu oft neu zu starten. Zwischen dynamic und ondemand wähle ich je nach Traffic-Profil: ondemand spart RAM bei sporadischen Lastspitzen, dynamic reagiert schneller bei Dauerlast.

| Hosting-Typ | Typisches Memory Limit | Tuning-Features | Einsatz |

|---|---|---|---|

| Shared Basic | 64–128M | Wenig Optionen | Kleine Blogs |

| Managed WordPress | 256–512M | OPcache, FPM-Profile | Wachsende Sites |

| VPS | 512M–unbegrenzt | Volle Kontrolle | Shops, Portale |

| webhoster.de (Testsieger) | bis 768M+ | OPcache & FPM-Optimierung | Performance-Fokus |

Datenbank und Plugins schlank halten

Ich räume die Datenbank regelmäßig auf, entferne alte Revisions, lösche abgelaufene Transients und bereinige Spam-Kommentare. Saubere Indizes beschleunigen Abfragen und verringern den Speicherbedarf pro Request deutlich. Bei Plugins prüfe ich Nutzen versus Kosten und ersetze Schwergewichte durch leichtere Alternativen. Cache-Plugins und ein sauberer Page-Cache senken dynamische Aufrufe und sparen RAM unter Last. Dieser disziplinierte Ansatz begrenzt den Peak-Verbrauch spürbar und macht Limits verlässlich.

Ich achte außerdem darauf, dass Query-Ergebnisse begrenzt und nur benötigte Felder geladen werden. In WordPress reduziere ich z. B. mit 'fields' => 'ids' den Speicherbedarf großer Listenansichten deutlich. Persistente Object-Caches entlasten die Datenbank und verkürzen Request-Laufzeiten; wichtig ist jedoch, interne In-Request-Caches nicht zu überziehen, damit nicht unnötig viele Daten im Prozess verbleiben.

Memory-Fragmentierung verstehen

Selbst wenn genug RAM scheint, kann Fragmentierung freie Blöcke in viele kleine Stücke aufteilen, die große Arrays nicht mehr aufnehmen. Ich beobachte deshalb die Muster von Allokation und Freigabe, vor allem bei Bild-, JSON- und Suchfunktionen. Kürzere Requests mit klaren Lebenszyklen der Daten senken die Fragmentierung. Auch OPcache und optimierte Autoload-Strategien reduzieren den churn im Speicher. Wer tiefer einsteigen möchte, findet Hintergründe zur Memory-Fragmentierung und deren Effekte auf reale Workloads.

Garbage Collection: Tücken und Stellschrauben

Die PHP-Garbage-Collection rettet Speicher, kann aber im Grenzbereich Spikes auslösen. Hohe Objektgraphen mit Zyklen zwingen die Engine zu häufigen GC-Läufen, was Requests streckt. Ich reduziere große Strukturen, nutze Streams statt Voll-Loads und lagere selten benötigte Daten in Zwischenschritte aus. In Edge-Fällen lohnt es sich, GC für kurze Tasks zu pausieren und kontrolliert wieder zu aktivieren. Eine praxisnahe Einführung liefert der Artikel Garbage Collection optimieren, der konkrete Stellschrauben erklärt.

Coding-Strategien gegen Peak-Verbrauch

Viele Speicherprobleme löse ich im Code. Statt große Mengen in Arrays zu laden, arbeite ich mit Generatoren, Pagination und Streams. Ich vermeide breit aggregierte Strukturen und schreibe Funktionen so, dass Zwischenergebnisse früh freigegeben werden können.

- Pagination: Große Listen in Seiten zerlegen, nur benötigte Felder laden.

- Streams/Generatoren: Dateien und Ergebnisse Stück für Stück verarbeiten.

- Chunking: Imports/Exporte in Blöcken statt Full-Loads.

- Formatwahl: JSON-Streams statt riesiger Arrays; wo möglich iterativ parsen.

- Bewusste Lebenszyklen: Variablen früh unsetten, Referenzen vermeiden.

// Beispiel: Dateien streamen statt Voll-Load

function stream_copy($src, $dst) {

$in = fopen($src, 'rb'); $out = fopen($dst, 'wb');

while (!feof($in)) { fwrite($out, fread($in, 8192)); }

fclose($in); fclose($out);

}

// Beispiel: große Arrays in Blöcken verarbeiten

foreach (array_chunk($bigArray, 500, true) as $chunk) {

process($chunk);

unset($chunk);

}

// WordPress: memory-arme Query

$q = new WP_Query([

'post_type' => 'product',

'posts_per_page' => 200,

'fields' => 'ids',

'no_found_rows' => true,

'update_post_meta_cache' => false,

'update_post_term_cache' => false,

]);

Für Bildverarbeitung entscheide ich bewusst über den Editor. Auf knappen Systemen ziehe ich bei Problemen einen Wechsel in Betracht:

// Imagick temporär umgehen (z. B. bei hohen Peaks)

add_filter('wp_image_editors', function() {

return ['WP_Image_Editor_GD', 'WP_Image_Editor_Imagick'];

});

Monitoring und Logging ohne Lärm

Ich aktiviere Logging mit sinnvoller Grenze und erfasse Fehler, Peaks und langsame Requests, ohne das System zu fluten. Query-Monitor und FPM-Statusseiten zeigen mir RAM, Ausführungszeit und Engpässe pro Endpunkt. In Logs suche ich nach Mustern wie gleichzeitigen 502-Fehlern, FPM-Restarts oder abrupten Abbrüchen. Kleine Lasttests nach jeder Änderung liefern schnelle Rückmeldung, ob ich die richtige Schraube gedreht habe. So stoppe ich stille Ausfälle, bevor echte Besucher sie spüren.

Praktisch hat sich ein „Basisset“ bewährt: FPM-Slowlog aktivieren, Error-Logs rotieren und Rate-Limits setzen, um Log-Fluten zu vermeiden. Im Monitoring korreliere ich CPU, RAM, Swap, FPM-Queue-Länge und Response-Zeiten. Sobald Swap wächst oder die FPM-Queue zeichnet, senke ich parallel die Concurrency (weniger Worker) oder optimiere die teuersten Endpunkte zuerst.

Spezialfälle: Admin, CLI, Container

Im Admin-Bereich sind Limits naturgemäß höher – hier fasse ich viele Daten an, generiere Vorschaubilder oder exportiere Listen. Mit WP_MAX_MEMORY_LIMIT grenze ich dieses Mehr gezielt auf den Admin ein. Für CLI-Jobs definiere ich Limits pro Task (z. B. php -d memory_limit=768M), damit schwere Exporte zuverlässig laufen, ohne das Frontend zu belasten. In Containern (cgroups) beachte ich, dass der Kernel harte RAM-Grenzen vorgibt; PHP sieht zwar sein memory_limit, wird aber bei Überschreiten der Container-Grenze trotzdem vom OOM-Killer beendet. Deshalb stimmen ich Container-Limit, FPM-Workerzahl und memory_limit gemeinsam ab.

Fallstricke gezielt vermeiden

- .htaccess-Direktiven greifen bei FPM oft nicht – besser

.user.inioder Pool-Konfiguration nutzen. - Unterschiedliche Ini-Dateien für CLI und FPM machen Tests inkonsistent – immer beide prüfen.

memory_limiterhöhen ohne FPM-Neustart hat keine Wirkung – Dienste sauber reloaden.- Zu hohe Limits erzeugen Swap-Last – lieber effizientere Queries und weniger Worker.

pm.max_requestsnicht auf unendlich setzen – damit bleiben Leaks ewig im Prozess.- Uploads/Exporte: POST/Upload-Limits (post_max_size, upload_max_filesize) sauber zur RAM-Kapazität abstimmen.

Kurz zusammengefasst: So verhindere ich Ausfälle

Ich prüfe zuerst Limit und Peak-Verbrauch, hebe das memory_limit moderat an und messe erneut. Parallel verschlanke ich Plugins, optimiere die Datenbank und räume unnötige Erweiterungen weg. Dann stimme ich OPcache und PHP-FPM ab, damit der Server genug Puffer für Lastspitzen hat. Mit sauberem Logging und kurzen Lasttests halte ich Risiken klein und erkenne stille Fehler schneller. So bleibt die Seite stabil, Suchmaschinen honorieren bessere Ladezeiten – und Besucher bleiben.