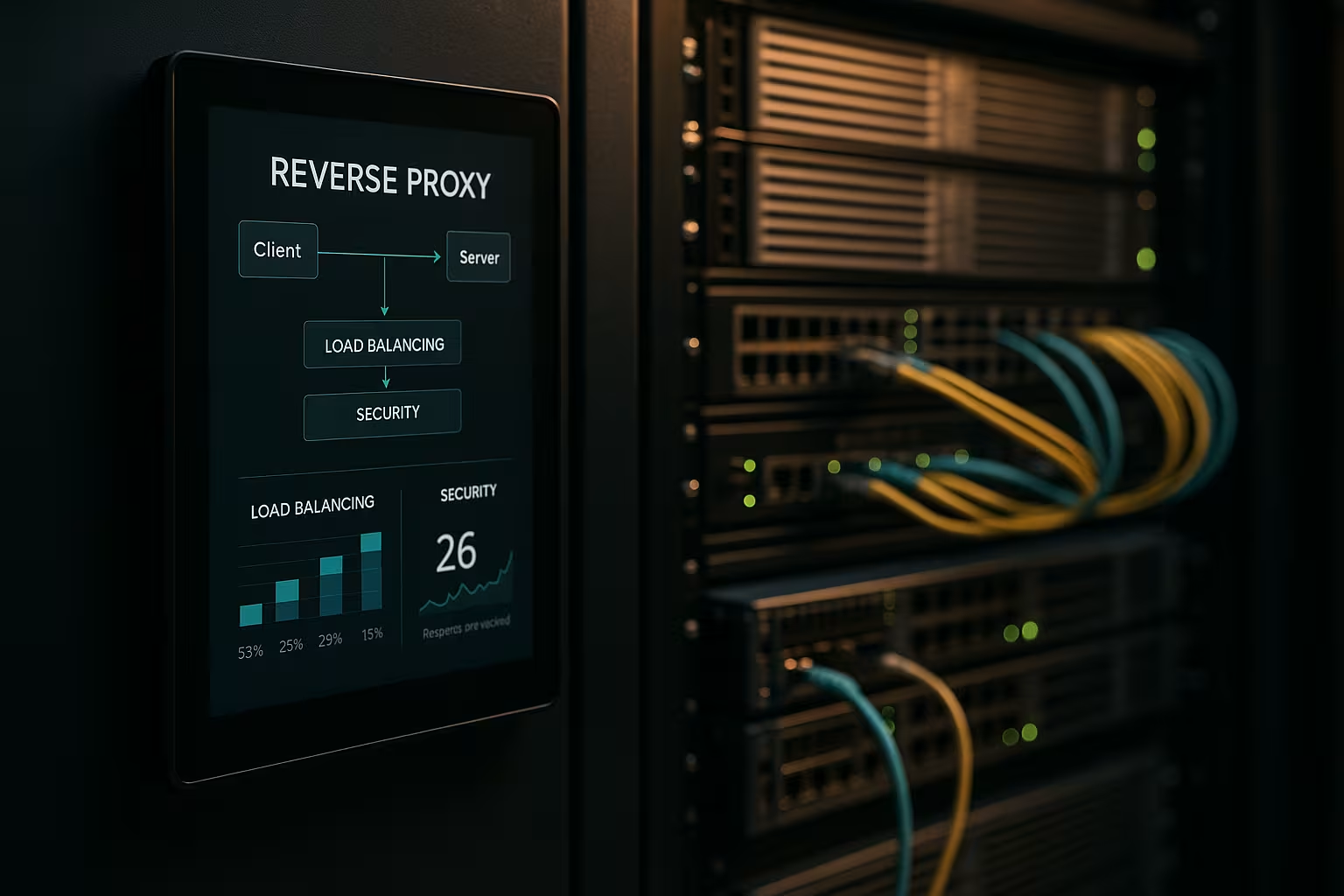

Eine Reverse Proxy Architektur beschleunigt Anfragen, schützt Backend-Systeme und skaliert Webanwendungen ohne Umbauten an den App-Servern. Ich zeige, wie ein Reverse Proxy Performance, Sicherheit und Skalierung im Tagesbetrieb messbar voranbringt.

Zentrale Punkte

- Performance durch Caching, SSL-Offloading und HTTP/2/3

- Sicherheit via WAF, DDoS-Schutz und IP/Geo-Blocking

- Skalierung mit Load Balancing und Health Checks

- Kontrolle dank zentralem Routing, Logging und Analyse

- Praxis mit NGINX, Apache, HAProxy, Traefik

Was leistet eine Reverse Proxy Architektur?

Ich setze den Reverse Proxy vor die Anwendungsserver und lasse ihn alle eingehenden Verbindungen terminieren. Dadurch kapsle ich die interne Struktur, halte IPs verborgen und minimiere direkte Angriffsflächen. Der Proxy entscheidet, welcher Service die Anfrage übernimmt, und er kann Inhalte zwischenspeichern. Er kümmert sich um TLS, Komprimierung und Protokoll-Optimierungen wie HTTP/2 und HTTP/3. So entlaste ich die App-Server spürbar und gewinne eine Stelle für Richtlinien, Auswertungen und schnelle Änderungen.

Performance-Optimierung: Caching, Offloading, Edge

Ich kombiniere Caching, SSL-Offloading und Edge-Auslieferung, um Latenzen zu drücken. Häufige Assets wie Bilder, CSS und JS bediene ich aus dem Cache, während dynamische Teile frisch bleiben (z. B. Fragment Caching). Mit Policies wie stale-while-revalidate und stale-if-error reduziere ich Wartezeiten und sichere die Auslieferung bei Störungen. TLS 1.3, HTTP/2 Push-Ersatz via Early Hints und Brotli-Komprimierung beschleunigen zusätzlich. Für internationale Nutzer routet der Proxy zu nahegelegenen Knoten, was Time To First Byte senkt. Ein Blick auf passende Vorteile und Einsatzszenarien zeigt, welche Stellschrauben sich zuerst lohnen.

Sicherheitslage verbessern: WAF, DDoS, Geo-Blocking

Ich analysiere Traffic am Proxy und filtere schädliche Anfragen, bevor sie Backend-Systeme erreichen. Eine WAF erkennt Muster wie SQL-Injection oder XSS und stoppt sie zentral. TLS-Terminierung ermöglicht Inspektion des verschlüsselten Datenstroms, danach leite ich sauber weiter. DDoS-Abwehr hängt am Proxy, der Anfragen verteilt, limitiert oder blockt, ohne Applikationen zu berühren. Geo- und IP-Blocking schneidet bekannte Quellen ab, während Rate Limits und Bot-Erkennung Missbrauch eindämmen.

Skalierung und High Availability mit Load Balancing

Ich verteile Last über Load Balancing-Algorithmen wie Round Robin, Least Connections oder gewichtete Regeln. Sticky Sessions sichere ich per Cookie-Affinität, wenn Sitzungen an einen Knoten gebunden bleiben müssen. Health Checks prüfen Dienste aktiv, damit der Proxy defekte Ziele automatisch aus dem Pool nimmt. Horizontale Skalierung klappt in Minuten: neue Knoten registrieren, Konfiguration erneuern, fertig. Für Tool-Auswahl hilft ein kurzer Load-Balancing-Tools Vergleich mit Fokus auf L7-Funktionen.

Zentrale Verwaltung und präzises Monitoring

Ich sammle Logs zentral am Gateway und messe Kennzahlen wie Antwortzeiten, Throughput, Fehlerquoten und TTFB. Dashboards zeigen Hotspots, langsame Endpunkte und Traffic-Spitzen. Kopfzeilen-Analysen (z. B. Cache-Hit, Age) helfen beim Feintuning von Cache-Strategien. Mit Correlation-IDs verfolge ich Anfragen über Services hinweg und beschleunige die Ursachenanalyse. Einheitliche Richtlinien für HSTS, CSP, CORS und TLS-Profile setze ich einmal am Proxy, statt in jedem Dienst separat.

Routen, Regeln und Releases ohne Risiko

Ich steuere Routing anhand von Hostname, Pfad, Headern, Cookies oder Geo-Informationen. So route ich APIs und Frontends sauber getrennt, auch wenn sie auf denselben Ports laufen. Blue-Green- und Canary-Releases setze ich direkt am Proxy um, indem ich kleine Nutzergruppen gezielt auf neue Versionen leite. Feature-Flag-Header helfen bei kontrollierten Tests unter realem Traffic. Wartungsfenster bleibe ich kurz, weil ich Routen in Sekunden umschalte.

Technologievergleich in der Praxis

Ich wähle das Tool, das zur Last, zum Protokoll und zu Betriebszielen passt. NGINX punktet bei statischen Inhalten, TLS, HTTP/2/3 und effizienten Reverse-Proxy-Funktionen. Apache glänzt in Umgebungen mit .htaccess, umfangreichen Modulen und Legacy-Stacks. HAProxy liefert sehr starke L4/L7-Balancierung und feine Kontrolle über Health Checks. Traefik integriert sich gut in containerisierten Setups und liest Routen dynamisch aus Labels.

| Lösung | Stärken | Typische Einsätze | Besonderheiten |

|---|---|---|---|

| NGINX | Hohe Performance, HTTP/2/3, TLS | Web-Frontends, APIs, Static Delivery | Brotli, Caching, TLS-Offloading, Stream-Modul |

| Apache | Modulare Flexibilität, .htaccess | Legacy-Stacks, PHP-lastige Installationen | Viele Module, feines Access-Handling |

| HAProxy | Leistungsfähiges Balancing, Health Checks | L4/L7-Load Balancer, Gateway | Sehr granular, ausgereifte ACLs |

| Traefik | Dynamische Discovery, Container-Fokus | Kubernetes, Docker, Microservices | Auto-Konfiguration, LetsEncrypt-Integration |

Implementierungsschritte und Checkliste

Ich starte mit Zielen: Performance, Sicherheit, Verfügbarkeit und Budget priorisieren. Danach definiere ich Protokolle, Zertifikate, Cipher-Suites und Protokollversionen. Routing-Regeln, Caching-Policies und Limits lege ich sauber fest und versioniere sie. Health Checks, Observability und Alarmierung richte ich vor Livegang ein. Wer direkt loslegen will, findet eine anleitende Übersicht unter Reverse Proxy einrichten für Apache und NGINX.

Best Practices für Performance-Tuning

Ich aktiviere HTTP/3 mit QUIC, wo Clients es unterstützen, und halte HTTP/2 für breite Kompatibilität bereit. Brotli setze ich für Textressourcen ein und lasse den Proxy Bilder effizient komprimieren. Cache-Keys definiere ich bewusst, um Variationen durch Cookies oder Header zu steuern. Ich minimiere TLS-Handshake-Zeiten, nutze Session-Resumption und setze OCSP-Stapling. Mit Early Hints (103) gebe ich dem Browser Vorab-Signale für kritische Ressourcen.

Sicherheits-Setup ohne Reibungsverluste

Ich halte Zertifikate zentral und automatisiere Erneuerungen mit ACME. HSTS zwingt HTTPS, während CSP und CORP Inhalte kontrollieren. Eine WAF-Rulebase starte ich konservativ und verschärfe sie schrittweise, um Fehlalarme zu vermeiden. Rate Limits, mTLS für interne Services und IP-Listen senken das Risiko im Alltag. Audit-Logs bleiben manipulationssicher, damit ich Vorfälle rechtssicher nachvollziehe.

Kosten, Betrieb und ROI

Ich plane Budget für Serverressourcen, Zertifikate, DDoS-Schutz und Monitoring. Kleine Setups starten oft mit wenigen virtuellen Kernen und 4–8 GB RAM für den Proxy, was je nach Anbieter im niedrigen zweistelligen Euro-Bereich pro Monat liegt. Größere Flotten nutzen dedizierte Instanzen, Anycast und globale Knoten, was dreistellige Euro-Kosten pro Standort bedeuten kann. Zeit spart die zentrale Verwaltung: weniger Einzelkonfigurationen, schnellere Release-Prozesse und kürzere Ausfallzeiten. Der ROI zeigt sich durch höhere Conversion, geringere Bounce-Raten und produktiveres Engineering.

Architekturvarianten und Topologien

Ich wähle die Architektur passend zum Risiko- und Latenzprofil. Einfache Umgebungen fahren gut mit einem einzelnen Gateway in der DMZ, das Requests an interne Dienste weiterreicht. In regulierten oder großen Umgebungen trenne ich Frontend- und Backend-Proxies in zwei Stufen: Stufe 1 termininiert Internet-Traffic und übernimmt WAF, DDoS und Caching, Stufe 2 routet intern, spricht mTLS und erzwingt Zero-Trust-Prinzipien. Active/Active-Setups mit Anycast-IP und global verteilten Knoten reduzieren Failoverzeiten und optimieren Nähe zum Nutzer. Bei CDNs vor dem Reverse Proxy achte ich auf korrekte Header-Weitergabe (z. B. X-Forwarded-Proto, Real-IP) und auf abgestimmte Cache-Hierarchien, damit Edge- und Gateway-Cache sich nicht gegenseitig blockieren. Multi-Tenant-Szenarien kapsle ich über SNI/TLS, getrennte Routen und isolierte Rate-Limits, um Nachbarschaftseffekte zu vermeiden.

Protokolle und Sonderfälle: WebSockets, gRPC und HTTP/3

Ich berücksichtige Protokolle mit speziellen Anforderungen, damit Features stabil bleiben. Für WebSockets aktiviere ich Upgrade-Unterstützung und Long-Lived-Connections mit passenden Timeouts. gRPC profitiert von HTTP/2 und sauberen Headern; H2C (klartext HTTP/2) vermeide ich am Perimeter zugunsten von TLS mit korrektem ALPN. Für HTTP/3 stelle ich QUIC-Ports (UDP) bereit und lege 0-RTT nur restriktiv frei, da Replays Risiken bergen. Streaming-Endpunkte, Server-Sent Events und große Uploads erhalten eigene Buffering- und Body-Size-Policies, damit der Proxy nicht zum Bottleneck wird. Bei Protokollübersetzungen (z. B. HTTP/2 außen, HTTP/1.1 innen) teste ich Header-Normalisierung, Komprimierung und Connection-Reuse gründlich, um Latenzen niedrig und Ressourcenverbrauch planbar zu halten.

Authentifizierung und Autorisierung am Gateway

Ich verlagere Auth-Entscheidungen an den Reverse Proxy, wenn es Architektur und Compliance erlauben. OIDC/OAuth2 integriere ich über Token-Prüfung am Gateway: Der Proxy validiert Signaturen (JWKS), prüft Expiry, Audience und Scopes und setzt geprüfte Claims als Header für die Services ab. API-Keys nutze ich für Maschinen-zu-Maschinen-Endpunkte und limitiere sie per Route. Für interne Systeme setze ich auf mTLS mit gegenseitiger Zertifikatsprüfung, um Vertrauen explizit zu machen. Ich achte darauf, sensible Header (Authorization, Cookies) nicht unnötig zu loggen und verwende Allow/Deny-Listen pro Route. Feingranulare Policies formuliere ich über ACLs oder Expressions (z. B. Pfad + Methode + Claim), wodurch ich Zugriff zentral steuere, ohne Applikationscode zu ändern.

Resilienz: Timeouts, Retries, Backoff und Circuit Breaking

Ich definiere Timeouts bewusst je Hop: Verbindungsaufbau, Header-Timeout und Response-Timeout. Retries aktiviere ich nur für idempotente Methoden und kombiniere sie mit Exponential-Backoff plus Jitter, um Thundering Herds zu vermeiden. Circuit Breaker schützen Backend-Pools: Erkennt der Proxy Fehler- oder Latenzspitzen, öffnet er den Kreis temporär, leitet nur noch stichprobenartig an das betroffene Ziel weiter und antwortet sonst früh, optional mit Fallback aus dem Cache. Outlier-Detection nimmt „schwache“ Instanzen automatisch aus dem Pool. Zusätzlich begrenze ich gleichzeitige Upstreams, aktiviere Verbindungswiederverwendung und nutze Warteschlangen mit fairer Priorisierung. So bleiben Services stabil, selbst wenn einzelne Komponenten unter Druck geraten.

Compliance, Datenschutz und PII-Schutz

Ich behandle den Proxy als Datendrehscheibe mit klaren Datenschutzregeln. Personendaten maskiere oder pseudonymisiere ich in Logs; Query-Strings und sensible Header werden nur whitelisting-basiert protokolliert. IP-Adressen kürze ich, wo möglich, und halte strikte Retention-Perioden ein. Zugriffe auf Logs und Metriken sind rollenbasiert, Änderungen werden revisionssicher dokumentiert. Für Audits verknüpfe ich Gateway-Events mit Change-Management-Einträgen, sodass sich Freigaben und Regelupdates nachvollziehen lassen. So erfülle ich Compliance-Anforderungen, ohne auf tiefe Einblicke in Performance und Sicherheit zu verzichten.

Kubernetes, Ingress und Gateway API

Ich integriere den Reverse Proxy nahtlos in Container-Orchestrierung. In Kubernetes nutze ich Ingress-Controller oder die modernere Gateway API, um Routing, TLS und Policies deklarativ zu beschreiben. Traefik liest Labels dynamisch, NGINX/HAProxy bieten ausgereifte Ingress-Varianten für hohen Durchsatz. Ich trenne Cluster-internes Ost/West-Routing (Service Mesh) vom Nord/Süd-Perimeter-Gateway, damit Verantwortlichkeiten klar bleiben. Canary-Releases setze ich mit gewichteten Routen oder Header-Matches um, während ich Health Checks und Pod-Readiness strikt definiere, um Flapping zu vermeiden. Konfigurationen versioniere ich als Code und teste sie in Staging-Clustern mit Lastsimulation, bevor ich sie produktiv schalte.

Betriebsreife: Konfigurationsmanagement und CI/CD

Ich behandle die Proxy-Konfiguration als Code. Änderungen laufen über Pull Requests, werden automatisch getestet (Syntax, Linting, Security-Checks) und in Pipelines ausgerollt. Ich nutze Previews oder Shadow-Traffic, um neue Routen unter Realbedingungen zu validieren, ohne Kundentransaktionen zu riskieren. Rollbacks sind in Sekunden möglich, weil ich Versionen tagge und atomar deploye. Sensible Secrets (Zertifikate, Keys) verwalte ich getrennt, verschlüsselt und mit minimalen Berechtigungen. Für Hochverfügbarkeit verteile ich Releases gestaffelt auf Knoten und erfasse Auswirkungen in Dashboards, damit ich bei Regressionen schnell gegensteuern kann.

Typische Stolpersteine und Anti-Patterns

Ich vermeide Fehlerquellen, die in der Praxis häufig auftreten. Cache-Poisoning verhindere ich mit strikter Header-Normalisierung und sauberem Vary-Management; Cookies, die das Rendering nicht beeinflussen, schließe ich aus dem Cache-Key aus. Redirect-Loops erkenne ich früh durch Tests mit X-Forwarded-Proto/Host und konsistenten HSTS/CSP-Policies. „Trust all X-Forwarded-For“ ist tabu: Ich vertraue nur dem nächsten Hop und setze Real-IP sauber. Große Uploads steuere ich über Limits und Streaming, damit der Proxy nicht puffert, was das Backend besser kann. Bei 0-RTT in TLS 1.3 achte ich auf Idempotenz. Und ich halte Body- und Header-Größen im Blick, damit einzelne Requests nicht die gesamte Worker-Kapazität binden.

Zusammenfassung für schnelle Entscheidungen

Ich setze auf einen Reverse Proxy, weil er Geschwindigkeit, Schutz und Skalierung an einer Stelle vereint. Caching, TLS-Offloading und HTTP/2/3 beschleunigen reale Ladezeiten deutlich. WAF, DDoS-Abwehr und IP/Geo-Kontrolle reduzieren Risiken spürbar. Load Balancing, Health Checks und Rolling Releases halten Dienste verfügbar, auch bei Wachstum. Mit NGINX, Apache, HAProxy oder Traefik finde ich für jedes Setup eine klare Lösung und halte den Betrieb beherrschbar.